体系结构发展的风向标:ISCA 2025 会议总结

Image credit: ISCA Conference

Image credit: ISCA Conference

本文作者:朱振华,徐策羽,王邦彦,刘时宜,杨朝辉,范心,余江南,王鸿懿,宋如意,刘奇,夏一然(以上排名不分先后)

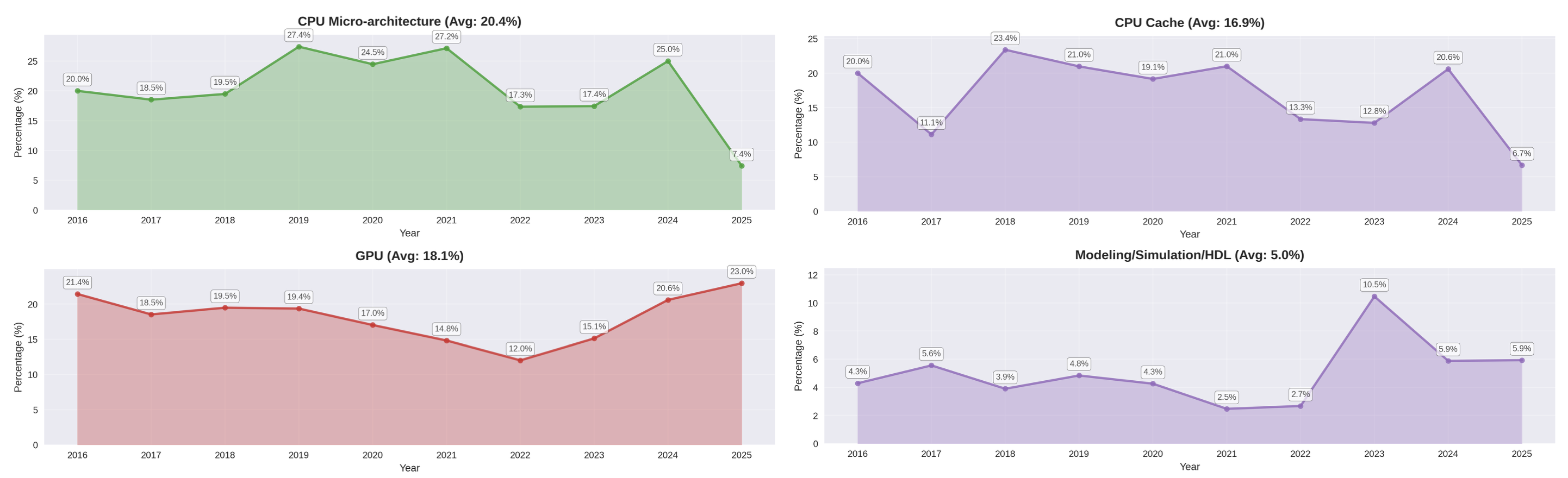

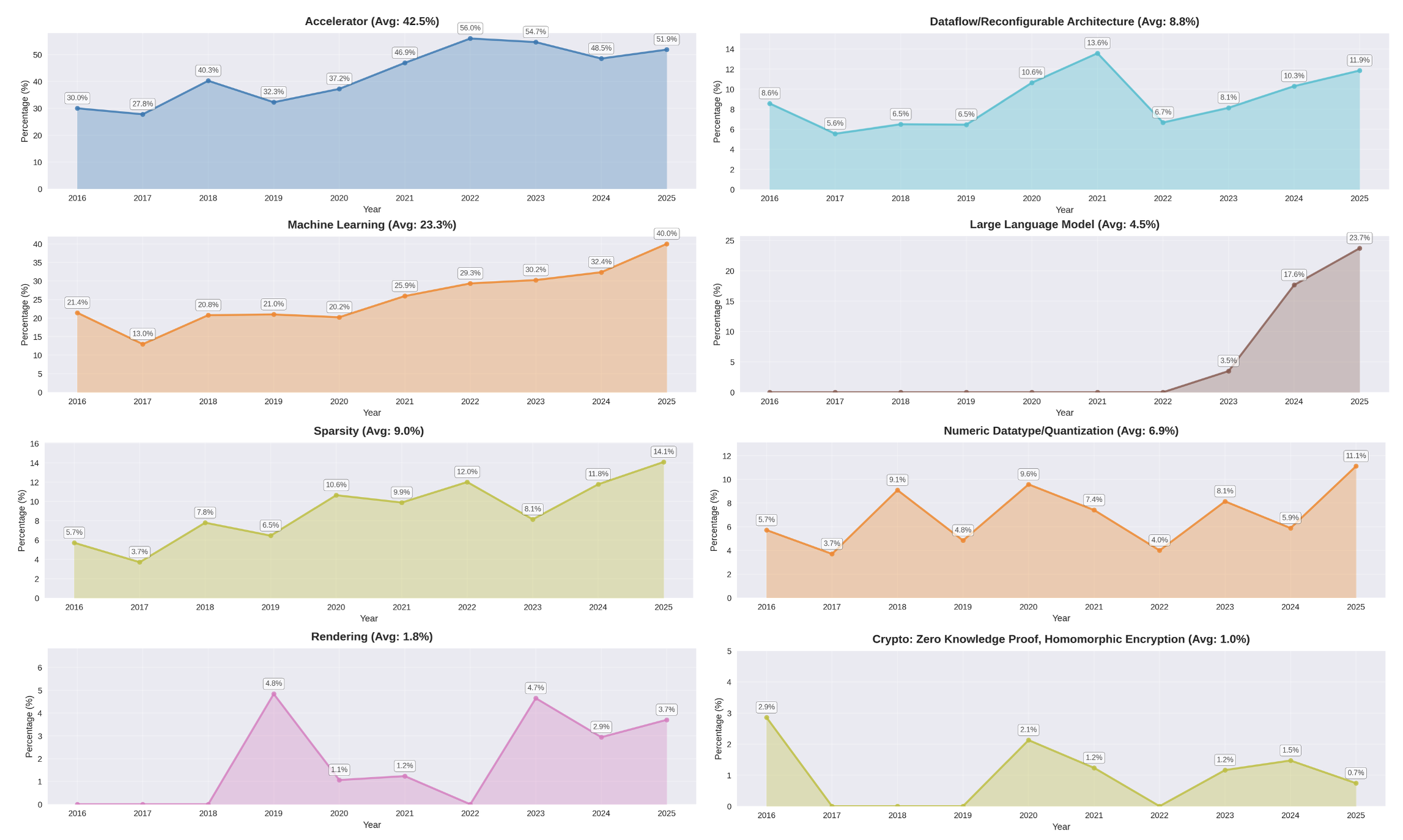

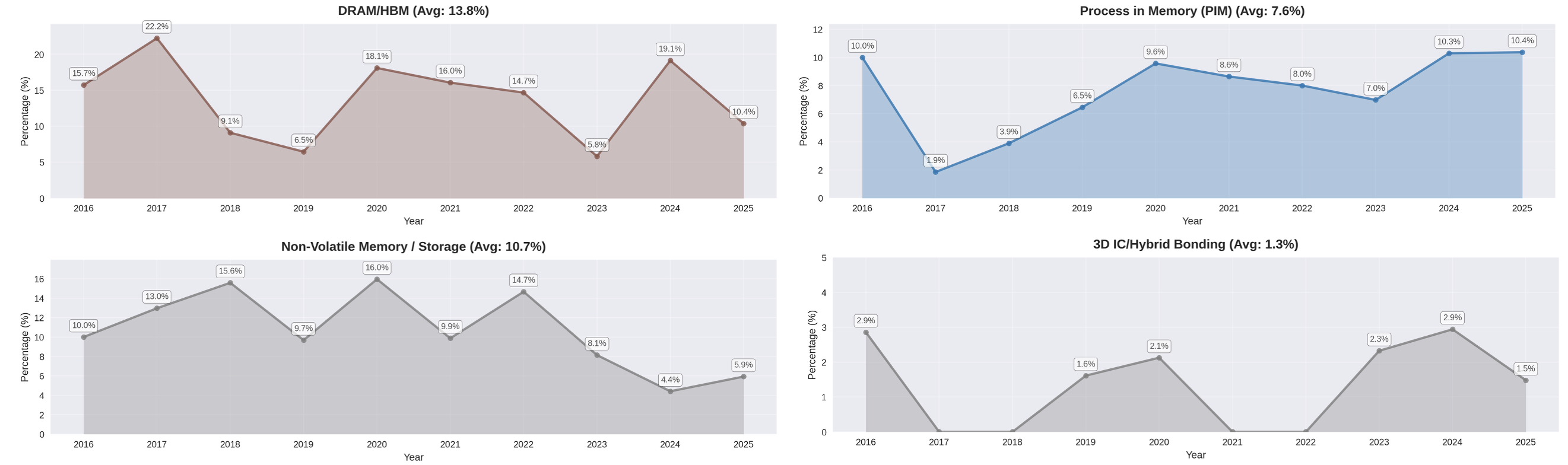

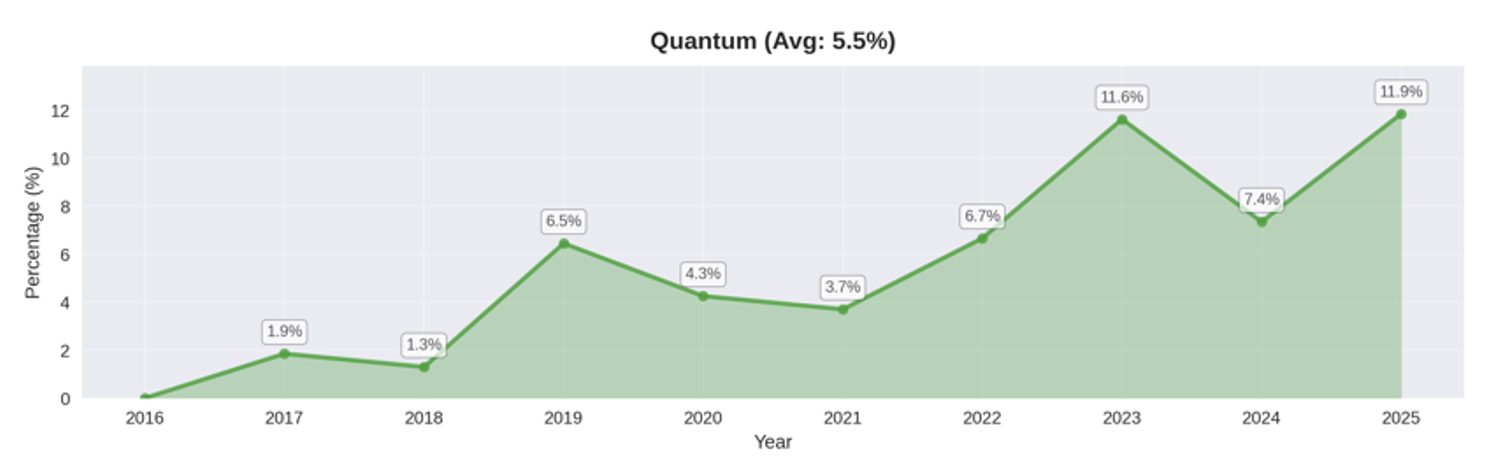

ISCA(The International Symposium on Computer Architecture)是计算机体系结构领域的顶级会议。第52届ISCA于2025年6月21日至25日在日本东京早稻田大学举行。今年的ISCA共收到了570篇论文投稿,最终录取132篇,录用率为23%。录取文章涵盖微架构设计、机器学习、领域定制加速器、量子计算、存算一体等众多话题。 下列图片汇总了2016年以来ISCA上各个话题文章的论文占比。传统的通用 CPU /GPU微架构、Cache及架构建模仿真的相关研究依然占据较高比重,但其占比自 2016 年以来趋于平稳并略有下滑。与之形成鲜明对比的是,加速器(Accelerator)和机器学习(ML/AI)相关研究持续攀升,成为增长最快的领域,稀疏计算、数据流与可重构加速器、量化等软硬件协同优化技术是其中最具代表性的子领域。ISCA 2025中加速器的论文占比超过50%,机器学习相关文章占比超40%。纵向对比显示,过去十年间机器学习在ISCA的占比稳定维持在20%-30%区间。其中,大模型毫无疑问是当下最热门的应用方向,面向大模型的架构与软硬件协同优化文章数量增长迅猛,ISCA 2025超过20%的文章关注大模型加速。除了AI算法外,图形渲染、隐私安全与数据加密等同样是ISCA近年来关注的热门应用方向。此外,存算一体和量子计算两个领域的文章数量在近年来保持较为平稳的增长趋势。值得一提的是,基于非易失器件的存算一体文章数量在近几年呈下降趋势,而内存级Near-Memory-Computing和外存级In-Storage-Processing的文章占比相对提升,Hybrid Bonding等先进封装技术的出现推动越来越多的研究者探索基于3D IC的存算一体架构设计。

通用微架构相关的ISCA文章数量占比

加速器相关的ISCA文章数量占比

存储器与存算一体相关的文章数量占比

量子计算相关的文章数量占比

ISCA 第三次东亚举办,见证中国体系结构研究影响力崛起

ISCA 自1973年创办以来仅有三次在东亚地区举办,分别为 2008 年北京、2016 年首尔,以及 2025 年东京。从地域分布来看,每一次在东亚地区举办的ISCA会议都极大提升了该地区学界与工业界的参与度,也成为观察本地区研究力量崛起的历史节点。

在 2008 年北京举办的 ISCA 上,仅有一篇国内单位的论文入选:来自复旦大学的 “From Speculation to Security: Practical and Efficient Information Flow Tracking Using Speculative Hardware”。该工作针对动态信息流追踪(Dynamic Information Flow Tracking, 又称 Taint Tracking)在缺乏硬件支持下效率低下的问题,首次提出利用处理器推测执行中的延迟异常机制来模拟 taint 状态,构建出一套无需专用硬件支持、低开销、适配灵活的追踪框架,该文章代表了国内团队在体系结构(硬件安全)领域的早期探索。论文第一作者陈海波,彼时在复旦大学攻读博士学位。如今他已是上海交通大学特聘教授、国家杰出青年基金获得者、IEEE Fellow,成为分布式系统与可信计算领域的全球权威学者。其成长轨迹恰是中国系统架构人才从本土培养到国际引领的缩影。

2016 年首尔举办的 ISCA 会议,中国团队共有两篇论文被接收。其中,来自中国科学院计算技术研究所的 “Cambricon: An Instruction Set Architecture for Neural Networks” 率先提出了面向神经网络的指令集架构,打破了早期 AI 加速器对“特定模型+硬编码控制”的依赖,被广泛视为后续 AI 加速器设计潮流的重要奠基之作。另一篇 “Power Attack Defense: Securing Battery-Backed Data Centers” 来自上海交通大学,关注于电池供电数据中心的安全性问题,体现了中国高校在系统安全与数据中心可靠性领域的深入探索与贡献。

到了 2025 年东京举办的 ISCA,中国团队的参与度实现飞跃:在全部132篇录用论文中,有 34 篇来自国内团队,论文内容涵盖微架构优化、AI 加速器、存储系统、量子计算等多个热点方向。这不仅是投稿数量上的增长,更意味着在体系结构各核心议题上,中国团队正在从“跟跑”迈向“并跑”甚至“领跑”。值得一提的是,来自北京大学孙广宇教授团队、上海交通大学张宸教授团队、香港科技大学谢源教授团队、东南大学司鑫教授团队及阿里巴巴达摩院的合作研究成果 “H2-LLM: Hardware-Dataflow Co-Exploration for Heterogeneous Hybrid-Bonding-based Low-Batch LLM Inference” 获会议最佳论文奖,这也是首篇来自中国团队的ISCA会议最佳论文,至此,国内团队集齐计算机架构领域四大(ISCA, MICRO, HPCA, ASPLOS)最佳论文。

从2008年的孤篇论文,到2025年高占比、多方向、出佳作,三次在东亚召开的会议见证了中国体系结构研究在全球舞台上的成长轨迹,也反映出国内在计算架构领域“从可见到可为”的历史跃迁。

上述趋势同样可以从ISCA 名人堂(Hall of Fame)的入选名录里加以印证。ISCA名人堂收录了在ISCA会议上累积发表文章不少于8篇的研究者,由体系结构领域著名学者威斯康辛大学的Mark D. Hill和Gurindar S. Sohi于1995年创建,旨在表彰在ISCA会议上做出重要贡献的杰出研究者。该榜单目前更新至ISCA 2024。在ISCA名人堂创立后的相当长时间里,在中国大陆(含香港、澳门、台湾)本土工作的学者几乎无人入选,反映出早期国内在体系结构顶会上的论文产出相对有限。然而近15年来情况开始改观,特别是2010年代后期以来,中国研究团队在ISCA上实现了一系列突破。第一位入选ISCA名人堂的中国学者是清华大学的魏少军教授(2017年入选),魏教授在可重构计算领域发表了多篇具有重要产学研影响力的ISCA论文。作为中国高校体系结构研究的资深带头人,魏少军教授见证并推动了国内在该领域从跟跑到部分并跑的历程。紧随魏少军教授的脚步,清华大学的刘雷波教授、尹首一教授同样在近几年内连续产出,标志着大陆学者入选名人堂的人数逐年增加。此外,近年来也有多位ISCA名人堂学者海外归来,比如香港科技大学的谢源教授(截止ISCA 2024共发表21篇ISCA论文)和清华大学的钱学海教授,他们进一步推动了中国在体系结构研究的崛起。除了清华大学外,中国其他高校和中科院也在近年逐步发力,相信我们可以在ISCA 2025更新后的名人堂中看到更多中国学者。

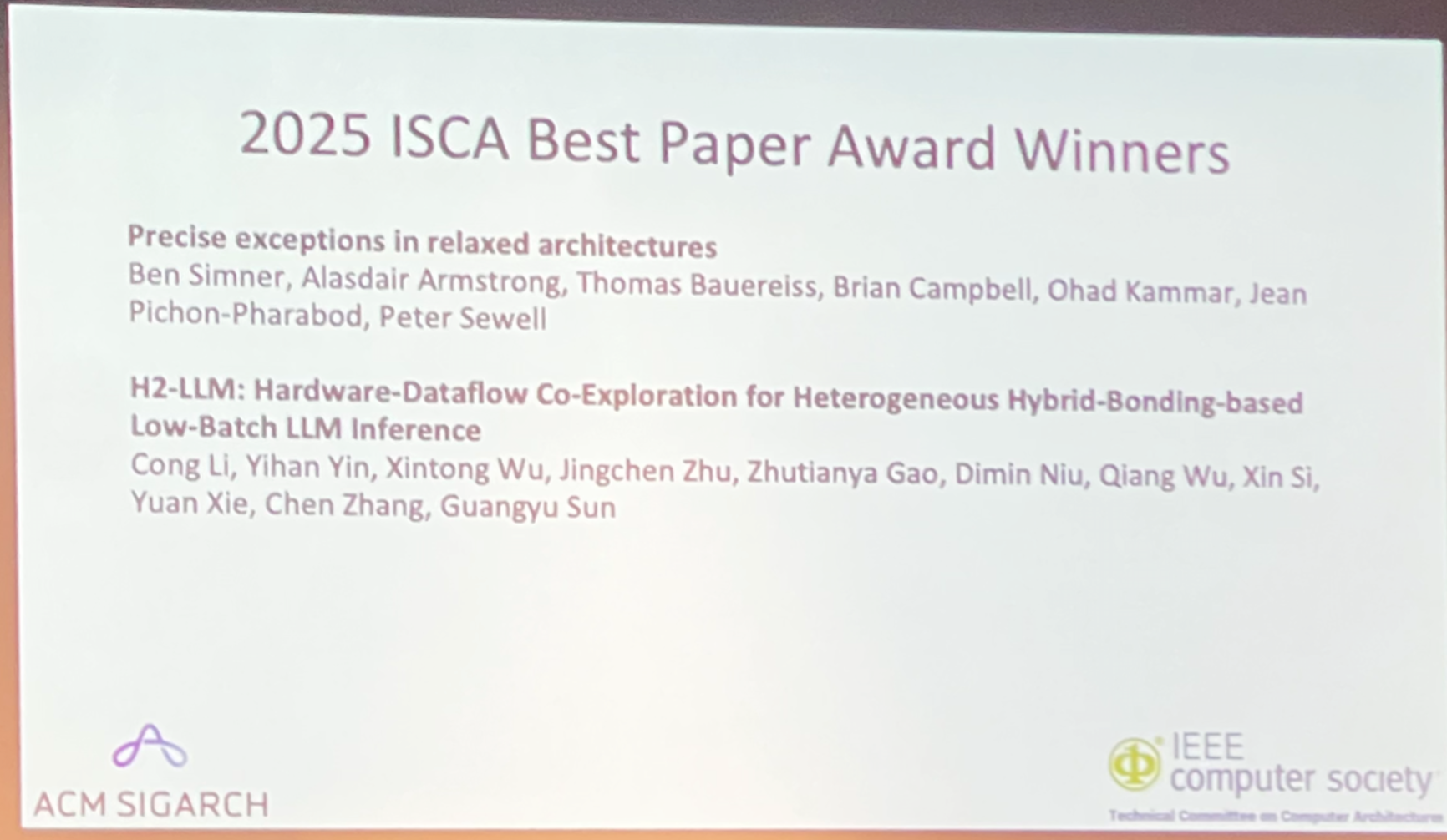

ISCA 2025最佳论文奖:新兴与传统并重,引领体系结构前沿发展

ISCA 2025的最佳论文奖评选结果充分体现了当今计算机体系结构领域新兴与传统并重、承前启后的发展态势。两篇获奖论文从不同维度展现了该领域的创新活力:既有运用现代理论工具重新审视经典核心问题的深度探索,更有紧跟时代脉搏、面向AI时代新应用需求的前瞻性研究。

ISCA2025最佳论文

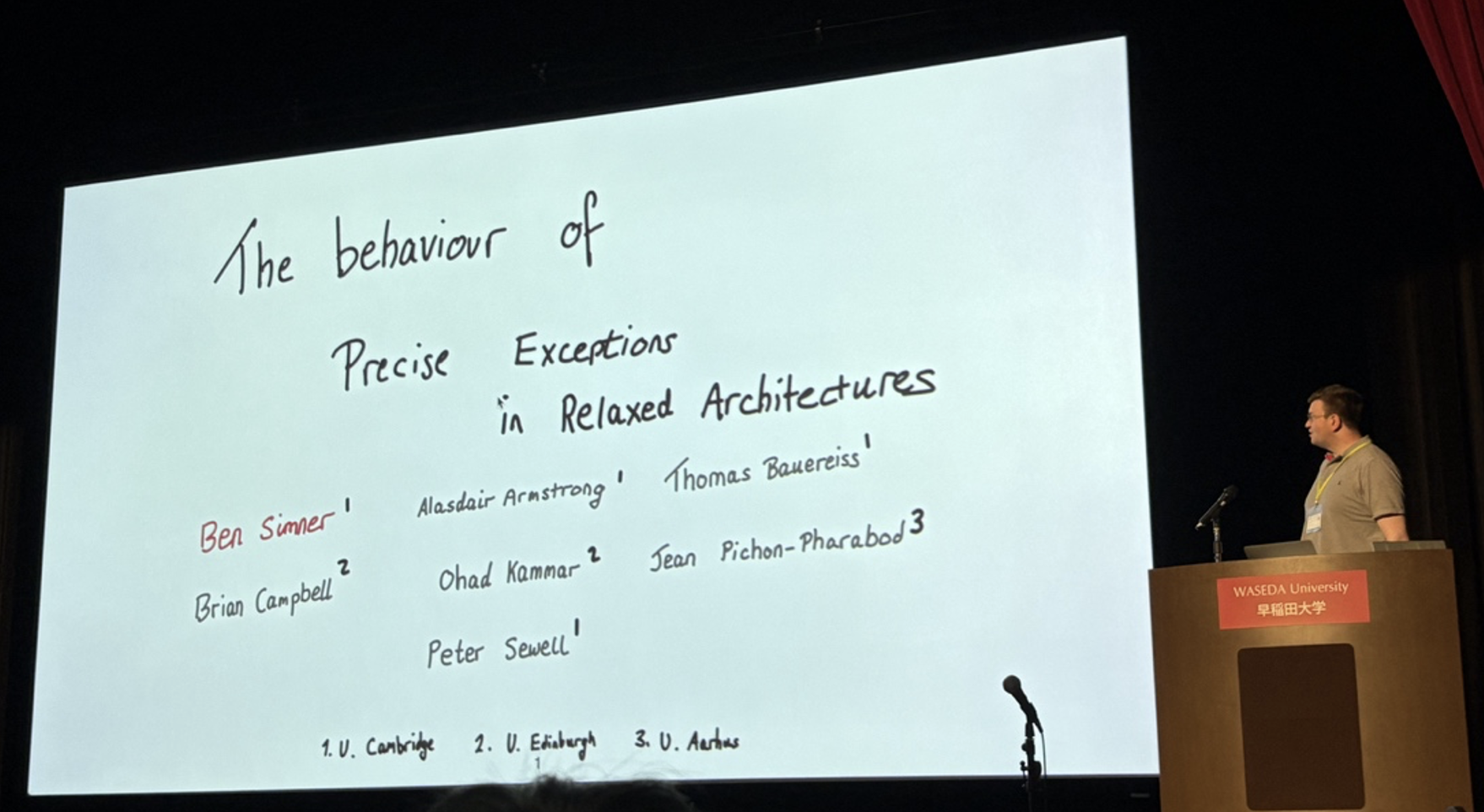

传统问题的现代突破:松散架构中的精确异常处理

来自剑桥大学、爱丁堡大学、奥胡斯大学等顶尖学术机构的研究团队凭借论文“Precise exceptions in relaxed architectures” 荣获最佳论文奖。该研究针对现代高性能处理器架构中的一个核心挑战——如何在松散内存模型环境中准确定义和处理异常。

传统的异常精确性定义基于60多年前的顺序执行模型假设,然而现代架构如Arm-A具有程序员可观察的松散内存行为,这使得传统定义变得不再适用。研究团队深入探索了异常在松散内存环境中的行为特征,包括乱序执行、推测执行以及跨异常边界的数据转发等现象,并开发了针对Arm-A架构的精确异常公理化模型。该工作不仅澄清了在松散内存设置中讨论异常所需的概念和术语,还探索了软件生成中断的松散语义,为Linux内核的RCU同步机制和Microsoft Verona编程语言运行时等复杂系统软件提供了理论基础。这项研究体现了"理论深化实践"的研究精神,为现代处理器架构规范的明确化定义做出了重要贡献。

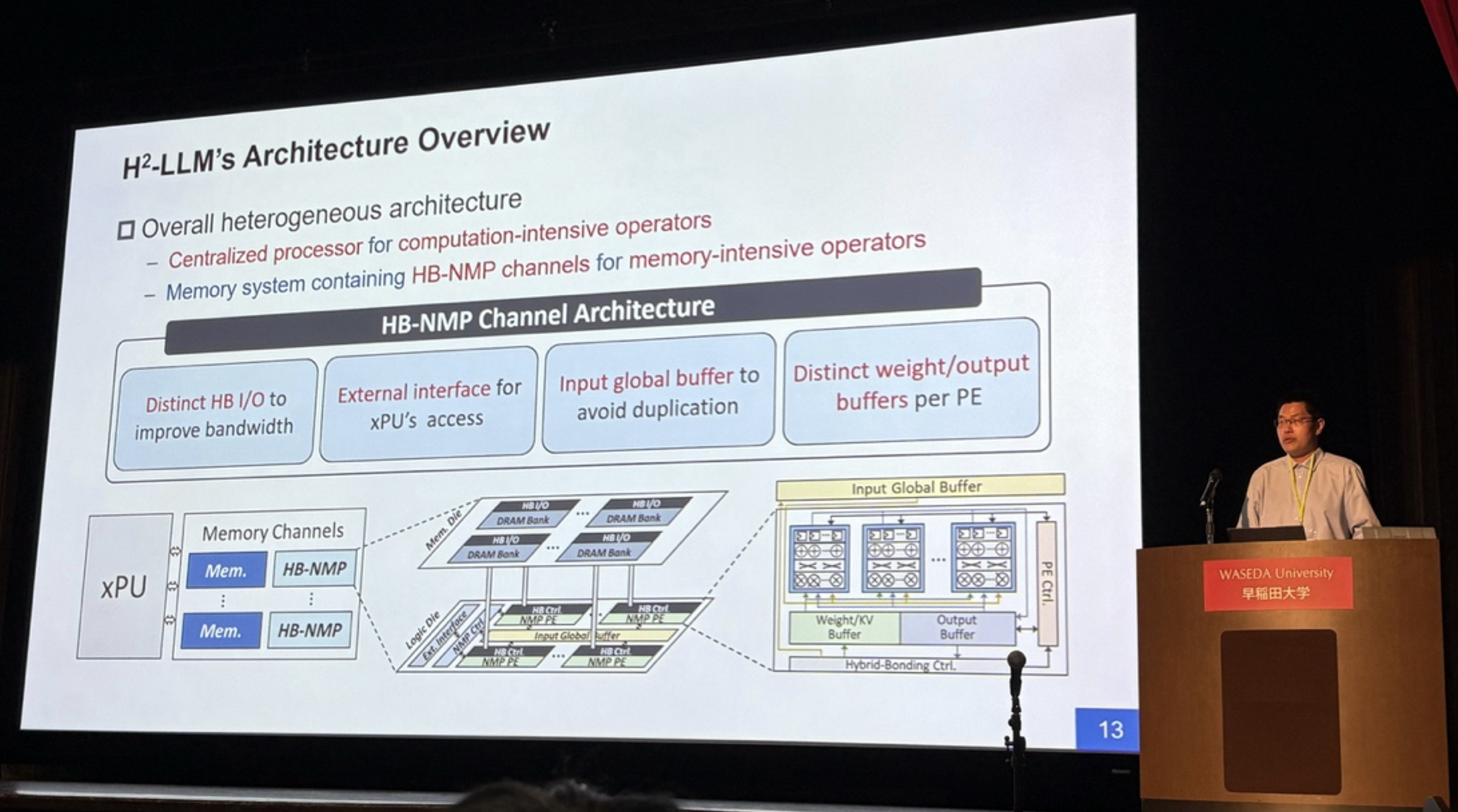

新兴应用的前沿探索:边缘侧LLM推理架构重大突破

另一篇获奖论文则展现了体系结构领域对人工智能时代新挑战的积极回应。来自北京大学孙广宇教授团队、上海交通大学张宸教授团队、香港科技大学谢源教授团队、东南大学司鑫教授团队及阿里巴巴达摩院的合作研究成果 “H2-LLM: Hardware-Dataflow Co-Exploration for Heterogeneous Hybrid-Bonding-based Low-Batch LLM Inference” 同样荣获最佳论文奖。

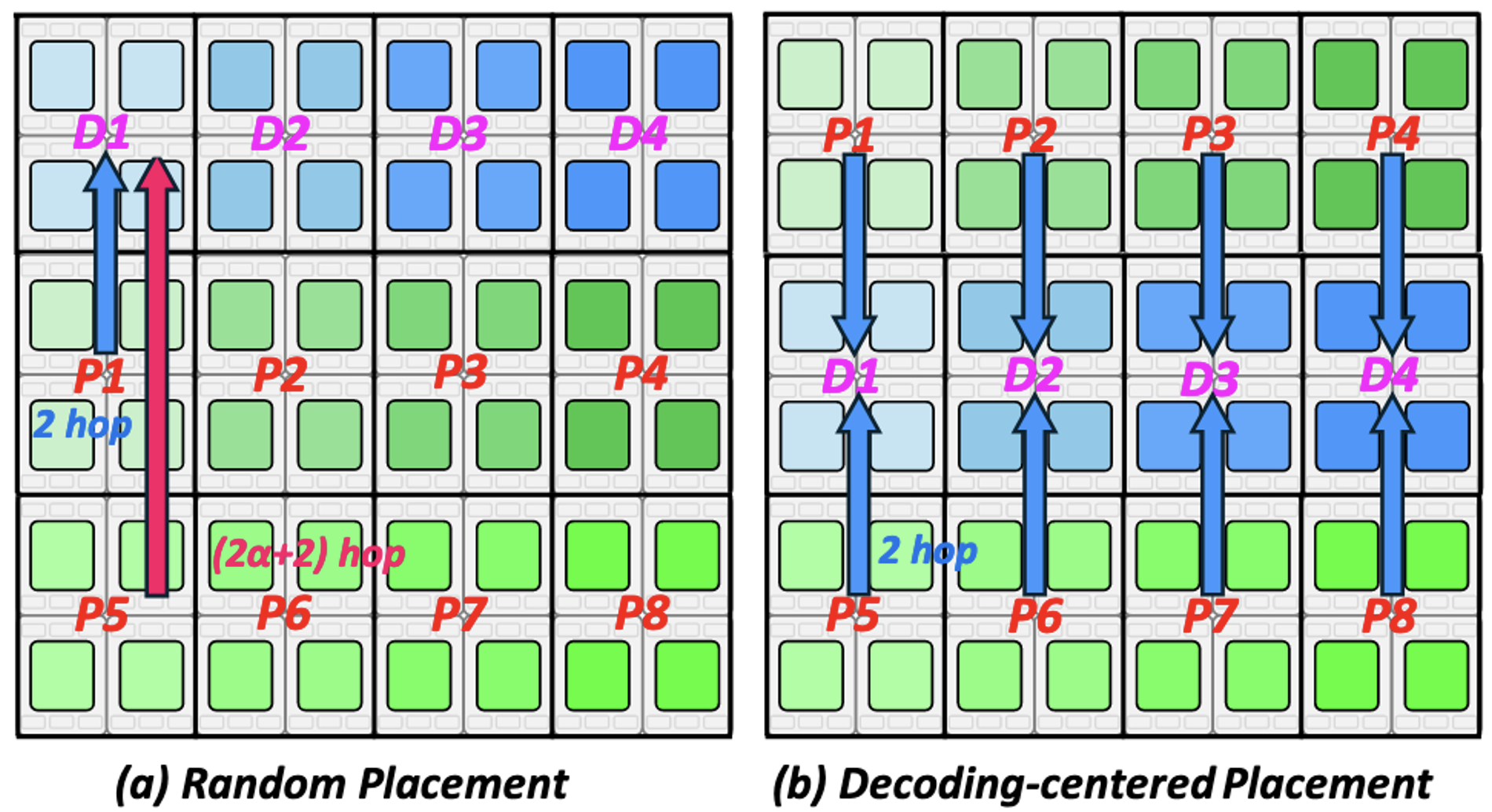

该研究针对边缘侧大语言模型推理面临的关键技术挑战,创新性地提出了基于混合键合(Hybrid Bonding)技术的异构加速架构H2-LLM。针对现有DRAM近存计算架构算力供给不足的问题,研究团队通过提出通用近存计算架构模板,抽象设计空间以协调工艺中算力与带宽的权衡,并采用"以数据为中心"的数据流抽象优化异构硬件资源利用,实现了计算密集型与访存密集型算子的协同加速。实验结果显示,相较于基线DRAM近存架构,H2-LLM在LLM推理的预填充(Prefill)和解码(Decoding)阶段实现了2.72倍的性能提升与1.48倍的能效优化,体现了"应用驱动架构创新"的发展理念。

方向1:人工智能加速器: 技术驱动 vs. 应用驱动

从CNN视觉模型的兴起以来,模型规模的指数级增长与日新月异的模型结构不断的为体系结构领域注入着新的活力重塑体系结构研究范式。2016年学者"ISCA的C已成为CNN的C"的论断,在Transformer时代得到更深刻的印证——2025年的今天,“ISCA的A正演进为AI的A"已成为学界共识。ISCA 2025创下三项里程碑:

- 录用论文135篇,创历史新高;

- 大模型加速器首获最佳论文奖;

- 首次设立LLM专题Session。

从小模型到大模型,从微架构到宏架构

随着模型参数规模从小到大的持续扩展,AI系统面临的挑战也从单一节点的计算效率演变为涵盖计算、通信与存储的全局优化问题。在硬件与系统微架构层面,包括模型量化支持、近存计算在内的技术成为提升能效比和计算密度的核心手段,直接影响单节点的推理与训练效率。而在更大尺度的系统宏架构层面,则需关注超节点的组网设计、高效的系统通信算法以及资源池化能力,以实现跨节点、跨集群的弹性扩展与高吞吐低延迟的协同计算。从微观到宏观,AI系统的构建正演变为一场跨越软硬件、融合算法与架构的系统性工程挑战。

在相关文章中,来自香港科技大学(广州)黄嘉逸教授团队的Chimera 通过系统性地分析通信模式,识别出在并行切换时的通信冗余,提出了一种通用且兼容各种并行组合的优化方法,该文章获ISCA 2025 Distinguished Artifact Award奖项。Chimera将相邻的通信操作符进行重排序并融合成更高效的通信原语。该方法不仅减少了通信总量,还避免了中间状态的冗余同步,显著提升了通信带宽和整体训练性能。此外,Chimera 兼容现有优化方法(如核融合和调度优化),为构建更高效的大模型训练系统提供了新的基础支持。

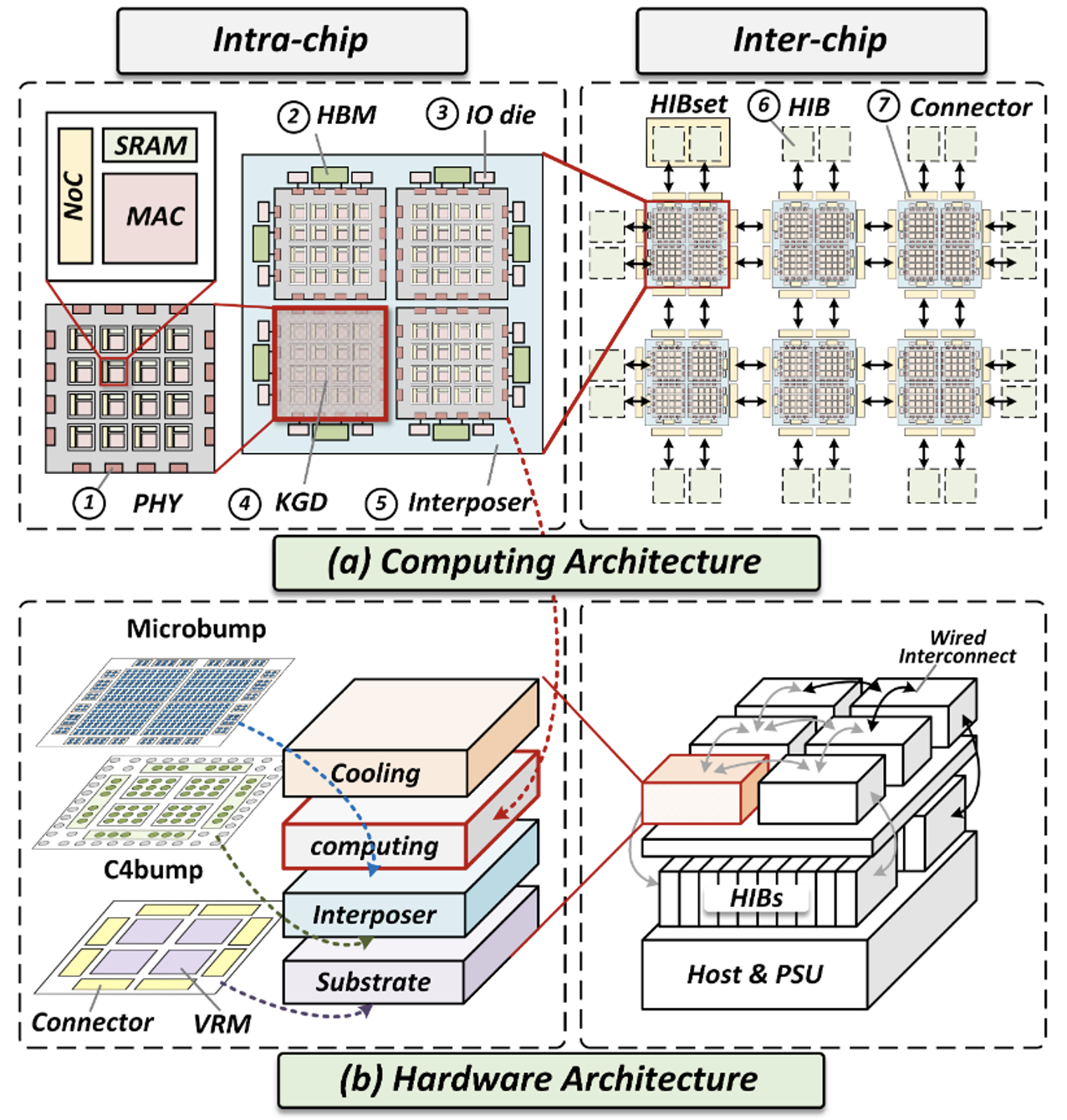

晶圆级计算、混合键合、光芯片百花齐放

随着晶体管的微缩逐步到达其物理极限,以及先进芯片的尺寸达到光罩尺寸 (reticle size),现在越来越难以通过继续传统的缩小晶体管尺寸、扩大芯片面积的方式提升单芯片集成度;另外一方面,现在的芯片性能在越来越多情况下被内存、通信带宽而非计算所限制,而这也是单纯缩小晶体管尺寸所难以解决的。

许多新兴制造工艺或许正是解决以上问题的一剂良药。从3D集成工艺到非易失存储器件再到芯粒 (chiplet) 技术,制造工艺上的演进能够带来集成度、内存带宽等技术指标上的颠覆性提升,也不断刺激着全芯片架构的不断涌现。本次ISCA会议上,我们主要看到了由三种新型工艺驱动的架构设计讨论:晶圆级计算 (wafer-scale computing)、混合键合 (hybrid bonding)、光计算 (photonic computing)。

晶圆级计算无疑是本次会议的一个焦点所在,ISCA 2025共接收了4篇文章。晶圆级计算是一种将整个硅晶圆作为单一超大规模计算系统的技术架构。其核心理念是不再将晶圆切割成小块芯片,而是直接在完整晶圆上构建计算阵列,通过片上互连网络将数千个处理核心连接起来,形成一个巨型的并行计算平台。相比传统GPU集群,这种架构可以提供约50倍的晶体管数量和6倍的片间带宽,同时通过短距离片上互连(<5mm)替代传统PCB走线(50-100mm),显著降低了通信延迟和功耗。此外,晶圆级系统消除了外部NVLink交换机、光互连等组件需求,大幅减少了系统复杂度和成本,同时支持近乎完美的线性性能扩展,可实现数百万AI优化计算核心的协同工作。

然而,晶圆级计算芯片也面临着一系列设计挑战。晶圆级计算的主要挑战在于如何在有限的晶圆面积约束下平衡计算、存储和通信资源的分配。由于晶圆总面积固定(约70,000mm²),增加DRAM容量会占用更多面积并消耗更多片间互连接口,导致可用计算资源和片间通信带宽的减少。同时,系统还面临互连距离限制(超过50mm会导致误码率增加10⁸倍)、封装可靠性约束、以及复杂的多层级设计空间优化问题。此外,缺乏细粒度的参数化建模框架和综合评估系统,使得在设计阶段难以实现计算架构和硬件架构的协同优化,这些都成为实现最优集成密度和性能的关键瓶颈。

对于这些问题,清华大学尹首一教授、胡杨教授团队发表的“Cramming a Data Center into One Cabinet, a Co-Exploration of Computing and Hardware Architecture of Waferscale Chip” 一文针对晶圆级芯片资源分配这一关键问题,通过计算与硬件架构的协同探索,有效解决了在有限晶圆面积下计算、存储、通信资源的最优权衡难题,并引入垂直集成架构约束实现了系统级优化。

晶圆级芯片架构

另一个晶圆级架构的代表性工作,同样来自清华大学尹首一教授、胡杨教授团队的WSC-LLM则专门聚焦于AI时代最重要的大语言模型(LLM)工作负载,通过架构与调度的协同设计,创新性地解决了LLM推理中预填充和解码阶段动态资源需求不匹配的问题,并提出了高效的分布式内存管理策略。这两项工作都体现了软硬件协同优化的设计理念,为突破传统多卡集群的内存和通信瓶颈、充分释放晶圆级计算潜力提供了重要的技术路径,代表了在新工艺约束下寻求最优系统性能的前沿探索。

面向LLM的晶圆级架构资源分配与管理

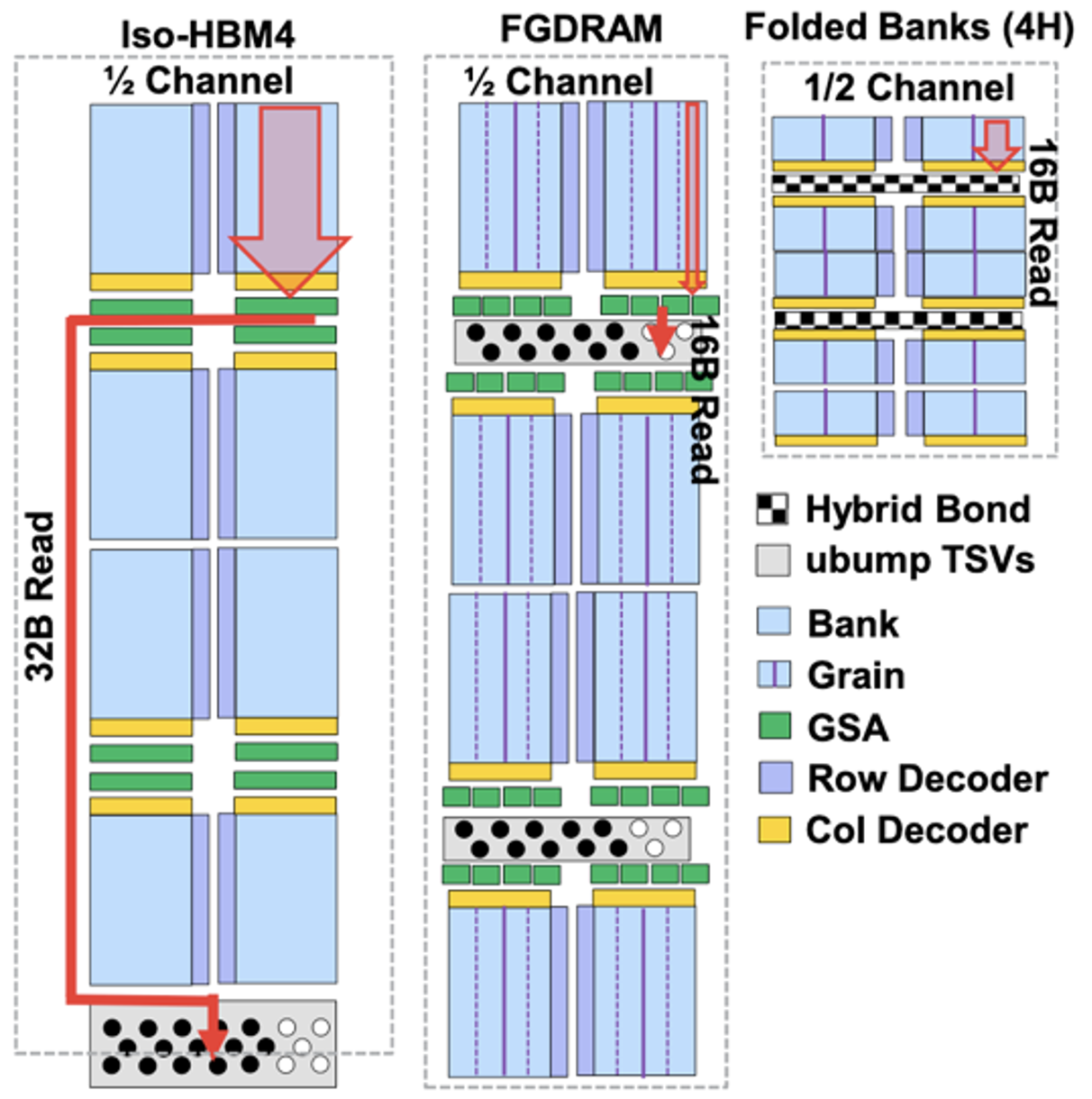

混合键合是一种先进的键合工艺,用于在3D IC的制造中形成上下相邻的两晶片间的物理及电路连接。相较于原先的微凸点键合(micro-bump bonding)工艺能够带来3D IC中垂直互联密度和带宽上数量级的提升。这一技术突破为解决长期困扰计算系统的"存储墙"问题开辟了新的路径。本次会议最佳论文奖的H²-LLM一文充分利用混合键合带来的高垂直互联密度优势,通过DRAM die与逻辑die的3D异构集成,解决了边缘LLM推理中计算能力与内存带宽的权衡难题,相比传统片内近存计算方案实现了2.72倍的性能提升。这篇论文也荣获本届ISCA会议最佳论文奖,将在本文后续部分中详细介绍。

光计算作为突破传统电子计算瓶颈的新兴技术,具有独特的优势与挑战。其核心优势在于光互连不受焦耳热、RF串扰和电容等传统电子器件的能效限制,能够实现极高的带宽密度,并支持在每个交叉点同时进行数十亿次乘累加(MAC)操作。然而,现有光计算工作往往局限于物理层面的概念验证,缺乏完整的系统级架构支持,特别是在内存系统设计、通用ML操作支持等方面存在显著不足。美国匹兹堡大学Jun Yang教授团队发表的 “LightML: A Photonic Accelerator for Efficient General Purpose Machine Learning” 提出了首个系统级光子交叉阵列架构,通过创新的内存和缓冲设计实现了超过80%的光子交叉阵列利用率。该工作巧妙利用相位调制器和傅里叶级数实现非线性函数计算,并通过电路级设计高效支持矩阵转置、批量归一化、ReLU等关键ML操作。LightML实现了325 TOP/s计算性能,功耗仅3W,相比GPU获得13.6倍能效提升,为解决AI时代"算力墙"问题提供了全新技术路径。

晶圆级计算、混合键合和光计算这三种新兴制造工艺代表了在摩尔定律逐步放缓背景下计算架构创新的重要方向。它们分别从超大规模集成、3D异构集成和新型物理计算原理三个维度突破了传统电子计算的根本限制,为解决当前芯片设计中面临的"存储墙”、“通信墙"和"功耗墙"等关键瓶颈提供了颠覆性的解决方案。本届ISCA会议上相关论文的集中涌现,不仅展现了学术界对这些前沿技术的高度关注,更预示着计算架构正在从传统的工艺驱动模式向工艺与架构深度协同优化的新范式转变。这种转变将为AI时代日益增长的算力需求提供更加高效、可持续的技术支撑,推动整个计算产业进入一个全新的发展阶段。

方向2:非AI应用域的领域定制加速器设计与优化

在AI驱动的各类应用场景中,AI计算毫无疑问是占据主要计算量的核心任务,而为了实现端到端的应用加速,非AI计算的“长尾”计算任务对低延迟、可重构、高能效的端侧定制硬件需求正在扩大。除了对AI算法进行加速外,ISCA 2025上有多篇关注于AR、VR、机器人控制等相关任务的领域定制加速器工作。

随着AR/VR和元宇宙应用的发展,对高质量、低延迟渲染提出了更高的需求。其中,光线追踪因其基于几何建模与光学物理模拟而实现的极高质量的渲染效果,是目前最为广泛应用的渲染技术。当前例如NVIDIA和AMD的消费级GPU中,均已部署RT Core等模块以支持高效的光线追踪。然而,越来越多研究者观察到,现有GPU在处理光线追踪任务时面临负载不均衡、计算冗余等性能瓶颈。因此,多个研究工作开始尝试从硬件架构层面对光线追踪任务进行定制优化。以AQB8为代表,其引入了深度学习中常用的多级量化方法,将原本以FP32进行的大量相交测试压缩至更轻量的数值格式。由于光线追踪的计算开销相对较高,这些工作主要关注于保持渲染质量的同时优化提升计算性能与能效。

与此相关的,ISCA 2025还有多篇工作观察到在许多通用计算场景下,GPU里的光线追踪核心(RT core)计算资源往往处于闲置状态,形成了潜在的资源浪费。因此,这些研究尝试“变废为宝”,将RT Core的算力迁移应用到具有相似计算模式的非图形任务中。例如,美国加州大学默塞德分校的Hyeran Jeon教授团队提出的Heliostat观察到了虚拟内存地址翻译中多级页表遍历与光线追踪中树遍历的相似性,因而只通过对RT core微小的改动就能支持常见的地址翻译。另一篇令人印象深刻的论文是加州大学河滨分校Hung-Wei Tseng 教授提出的RTSpMSpM,该工作聚焦于稀疏矩阵-稀疏矩阵乘法。稀疏矩阵乘法只对索引匹配的非零元素执行乘加操作,这一稀疏匹配模式与光线追踪中“仅在命中时触发计算”的逻辑类似。作者在仅进行轻量硬件修改的前提下,将RT Core引入SpMSpM计算路径,相比NVIDIA cuSPARSE库实现,取得了 3倍左右的性能提升。这类通过识别“计算特征相似性”来复用图形硬件的策略,为RT Core等专用资源在通用加速中的再利用打开了新思路,也为今后的异构系统设计提供了一个具有优秀发展潜力的方向。

利用RT Core和光线追踪实现稀疏矩阵计算

NeRF和3DGS等这类神经渲染方式也是最近AR/VR算法和硬件研究的热点之一, 体系结构的另一个顶会MICRO 2023的Best Paper就颁给了设计NeRF加速器的工作。相比于光线追踪,神经渲染能从数据集上学习出场景表示,然后可以从任意视角进行渲染,其优势在于很高的场景重建与图像渲染速度。目前这些硬件加速工作主要从端侧场景出发,通过算法-硬件协同设计来实现高帧率、低能耗的实时神经渲染。其中代表性的是来自寒武纪的工作Cambricon-SR,该工作通过在场景表示中引入稀疏编码表并进行定制化架构设计,相比于A100 GPU实现了上千倍的加速和能量效率提升,展现了极佳的优化性能。美国纽约大学的Sai Qian Zhang教授团队的 “Process Only Where You Look” 结合VR应用中的人眼注视行为进行软硬件协同优化,设计了轻量级的人眼追踪AI模型,在眼跳(saccadic motion)阶段跳过高精度的跟踪与渲染,结合事件驱动的空间裁剪技巧与专用加速器设计,在保证渲染质量的前提下,将端到端延时降低3.9倍。

此外,作为近期热门的研究方向之一,ISCA上也开始出现针对具身智能领域下特定任务的加速器硬件设计工作。这些工作与目前多样化发展的具身智能算法密切相关,关注在操作、定位、感知等不同的细分任务上。例如中科院计算所甘一鸣研究员团队提出的Dadu-Corki,利用软硬件协同设计思想用于加速LLM使能的机器人操控任务,特别是针对实时、高频控制的复杂动态场景进行加速。清华大学汪玉教授团队的IDEA-GP、美国威斯康辛大学麦迪逊分校Georgios Tzimpragos教授和罗切斯特大学Yuhao Zhu教授团队提出的SEAL等工作关注于传统方法下的机器人感知和定位任务。具身智能加速硬件目前一方面需要有通用性,支持同场景下多种相关的算法,从而能适应未来的发展趋势;另一方面则是关注与低延时和高实时性,满足机器人对操作或者感知速度的需求。

方向3:AI时代的存储系统设计与优化

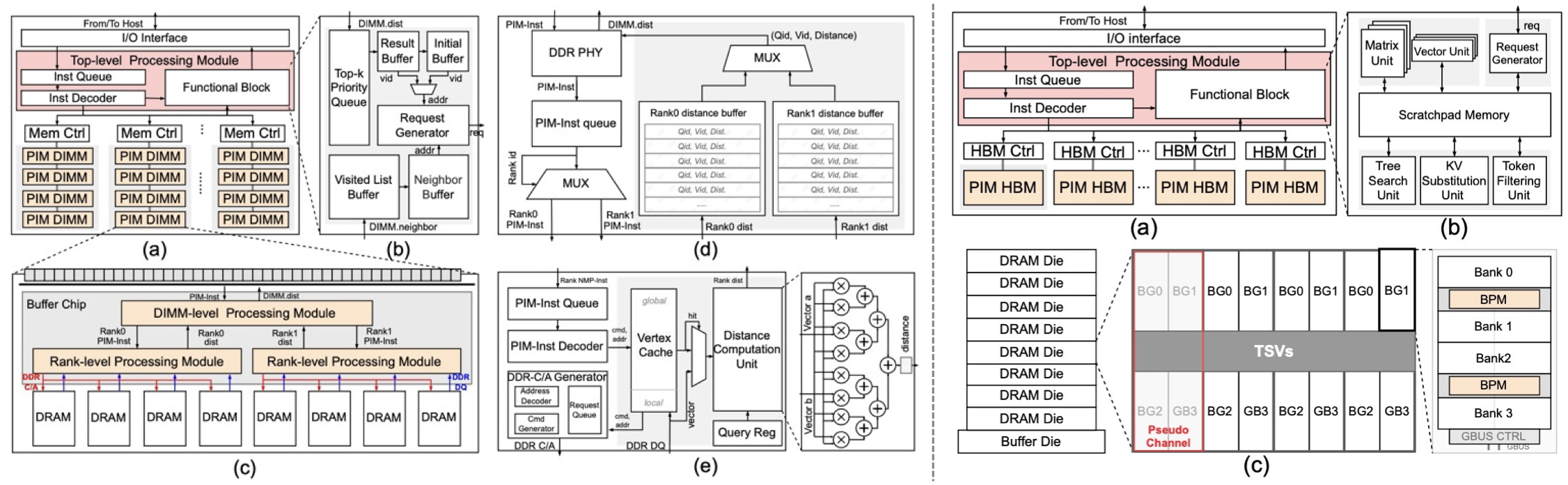

在ISCA 2025中,一共有5个Session与存储系统相关,内容涵盖前沿存储技术探索、外存系统优化、存算一体与存储加速器以及存储系统安全性研究。基于ISCA 2025的相关文章,我们将体系结构视角下的存储系统发展总结为如下三个重要趋势。

应用驱动的存储系统功能扩展:检索任务在大模型时代的“文艺复兴”

如何面向实际任务负载,设计“快速读写”的存储系统,是体系结构领域经久不衰的重要话题。在ISCA 2025中,“应用驱动”成为回答这一问题的关键——结合应用特征进行软硬件协同优化,降低冗余访存量,设计专用存算架构,充分挖掘存储器内部带宽。相关文章主要关注检索增强生成(Retrieval-augmented generation, RAG)、数据库(Database)、图神经网络(Graph Neural Network, GNN)、生物信息学处理等应用场景。其中,RAG与近邻搜索共有5篇文章入选存储系统的相关session,成为这一方向最热门的话题。

RAG是一种将外部检索到的相关信息动态融入生成任务中的技术,先通过向量检索模块从外部知识库中获取相关信息,再将检索结果作为附加上下文输入到生成模型中,以提升生成的准确性与一致性。从硬件架构的角度,RAG中的检索任务具有存储需求高、计算相对简单的特征,因此,将计算任务“下放”到内存与硬盘里去执行,利用Processing-In-Memory与In-Storage-Computing的思想对存储系统进行计算功能的扩展,可以有效缓解CPU/GPU在信息检索过程中的数据传输压力。

面向检索任务的专用硬件架构曾是体系结构领域的重要研究话题,如MICRO'19的TensorDIMM、ISCA'20的RecNMP和MICRO'23的DF-GAS,这些架构普遍关注于基于检索任务的推荐系统优化。在大模型越来越强的时代背景下,“信息检索”的应用场景也从经典的推荐系统任务,扩展到了检索生成一体化。在一些工作负载下,检索召回的时间可占端到端时间的60%,也使加速RAG中的检索任务变得愈发重要,今年ISCA的相关论文可以被称为检索任务的“文艺复兴”。

![RAG中不同计算阶段的延时占比。其中,Llama2-34B运行在A100 GPU上,其他组件运行在Intel Xeon CPU上。[Ref: In-Storage Acceleration of Retrieval Augmented Generation as a Service]](/post/2025/25.09.08-isca-summary/assets/index/1757567044878_image.png)

RAG中不同计算阶段的延时占比。其中,Llama2-34B运行在A100 GPU上,其他组件运行在Intel Xeon CPU上。[Ref: In-Storage Acceleration of Retrieval Augmented Generation as a Service]

ANSMET, DReX与HeterRAG三篇文章关注在内存(Memory)层级的近存储检索架构设计,旨在通过近存储计算单元,充分挖掘DRAM的内部带宽,降低数据搬运的额外开销。其中,清华大学高鸣宇教授团队的ANSMET与美国康奈尔大学Mohammad Alian教授团队的DReX均采用了软硬件协同优化的思想,通过“基于距离下界的提前早停”和“基于符号一致性的向量过滤”等方法,降低存储访问量与冗余计算量。华中科技大学金海教授、廖小飞教授团队的HeterRAG在检索之外更进一步,设计了基于异构DRAM的检索生成一体化架构,将检索任务交给高容量、低成本的 DIMM-PIM,而生成任务则交给高带宽的 HBM-PIM,并通过局部性感知的调度优化与细粒度并行,实现端到端的带宽–容量均衡与能效最大化。

HeterRAG:(左)检索部分(右)生成部分

苏黎世联邦理工学院Onur Mutlu教授团队设计的REIS与加州大学圣地亚哥分校Hadi Esmaeilzadeh教授团队的RAGX两篇文章侧重于在外存(Storage)层级支持检索与嵌入计算,通过利用 SSD/Flash 的内部并行与带宽,显著减少主机–外存之间的数据搬运延迟。REIS的特点在于保持现有SSD硬件不变,充分利用现有硬件单元和存储空间提高近似近邻搜索效率。REIS利用In-Storage-Embedded-Core以及SSD 控制器支持倒排文件(Inverted File)的相似性计算与查找,优化嵌入表信息在SSD内的数据布局,并使用NAND Flash中保留的Out-of-Band (OOB) 区域存储额外的地址等信息。与之对应的,RAGX在SSD内部增加了可编程加速器,一方面以脉动阵列的模式支持基于小规模语言模型的查询嵌入(query embedding),另一方面以向量模式可以在检索阶段直接从NAND阵列中读取嵌入表。除了支持嵌入计算外,RAGX实现了多种检索算法与数据结构的统一支持,包括HNSW与倒排索引等。

存算一体的下半场:从“架构设计”到“软件栈-架构协同优化”

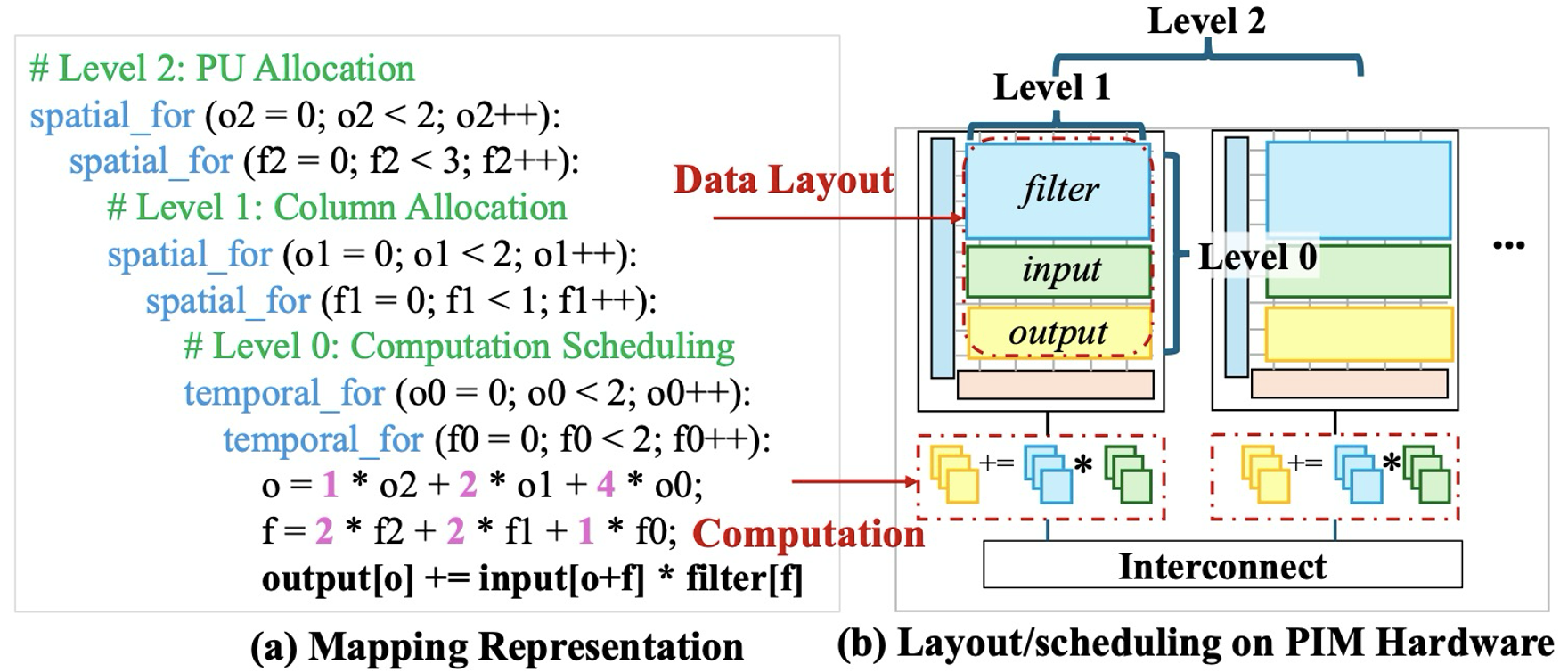

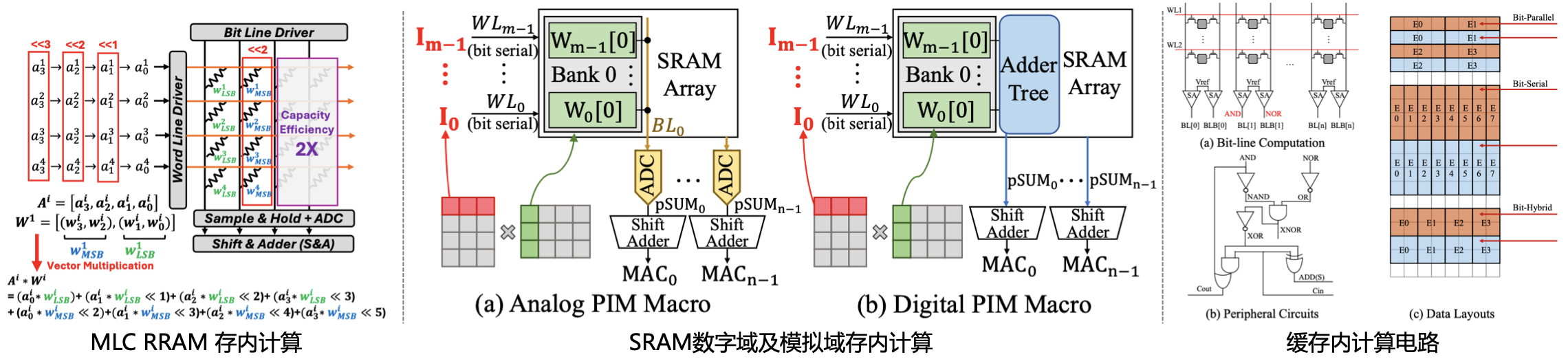

存算一体架构旨在让计算发生在数据存储的位置,从而降低存储器和处理器之间的数据搬运,打破冯·诺依曼架构的存储墙瓶颈。存算一体的设计思想可以追溯到二十世纪七十年代的Logic-in-Memory(LiM),受限于技术成熟度较低和应用需求不明确等问题,LiM未能实际落地应用。近十年来,得益于RRAM等非易失存储器件的发展和应用侧日益提升的高效访存需求,存算一体技术自ISCA'16的PRIME与ISAAC开始迎来了复兴。今天的典型存算一体技术包括面向矩阵向量乘的模拟域存内计算、面向逻辑计算的数字域存内计算以及在存储阵列外放置计算单元的近存储计算。在ISCA 2025,存算一体的相关文章呈现出近存储计算成为主流、由“架构设计”到“软件栈-架构协同优化”的发展趋势,表明体系结构领域愈加关注存算一体的生态建设,在追求高性能、高能效之余还要做到硬件可用、好用。

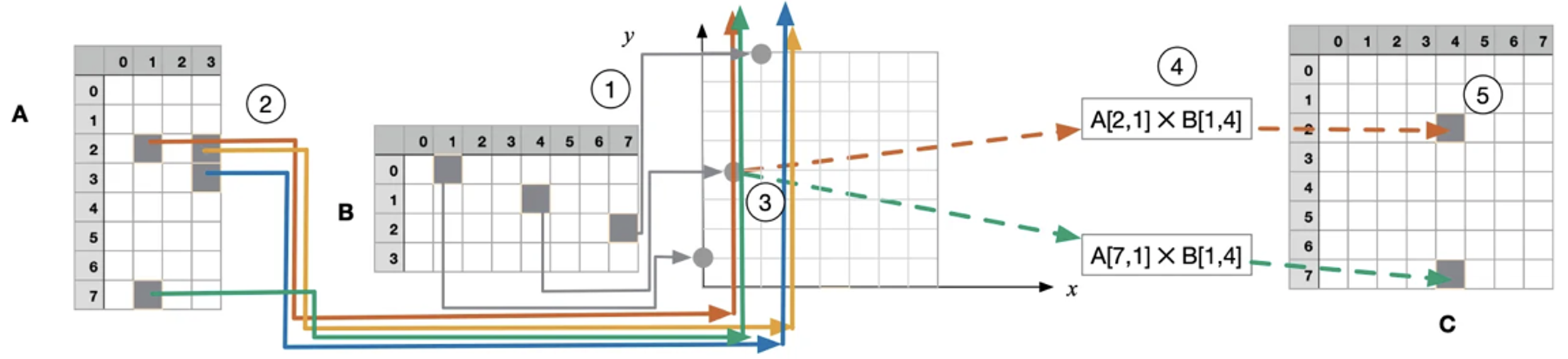

韩国首尔国立大学Hyojin Sung教授团队的ATiM和苏黎世联邦理工学院Lana Josipović教授团队与加州大学圣地亚哥分校的Tajana Rosing教授团队联合提出的OptiPIM是两篇典型的存算一体编译优化工作,两者均面向DRAM存算一体架构,基于架构特性分析,将算子映射问题形式化为可自动求解的优化任务,从而自动生成可执行代码及优化的数据布局。值得一提的是,这两项工作均已开源,并获得了Artifact Available, Artifact Evaluated以及Results Reproduced三个Badge。ATiM面向商用存算一体产品UPMEM设计了基于搜索的优化张量编译器,通过复用并扩展TVM的调度原语,进行主机侧与存算一体单元的联合编译寻优与代码生成,自动搜寻最优的 tiling、并行与缓存策略。基于TVM,ATiM提升了UPMEM架构的软件可编程性,用户无需手写UPMEM的低级代码即可获得高达8.21×的性能加速。OptiPIM更注重面向广义DRAM存算一体架构(包括近存计算与存内计算),解决数据布局与循环的优化问题。无独有偶,笔者发表在HPCA'25的UniNDP同样对该问题进行优化。不同于UniNDP关注在细粒度性能建模与基于启发式的映射策略搜索,OptiPIM对性能与约束条件进行粗粒度系统性建模,将算子映射问题描述成整数线性规划(Integer Linear Programming, ILP)问题,4分钟内即可求得算子向DRAM PIM的全局最优映射。OptiPIM同样获得了本次会议的Distinguished Artifact Award奖项。

OptiPIM优化目标

在存内计算架构方面,ISCA 2025收录了三篇文章,数量较之前有所下降,包括一篇RRAM PIM以及两篇SRAM PIM工作。三篇工作均采用系统级的软硬件协同优化方法,形成软件策略和硬件电路的闭环优化,提高计算准确率与能效。加州大学圣地亚哥分校Mingu Kang 教授团队的HyFlexPIM在RRAM单元上灵活切换single-level cell (SLC) 与 multi-level cell (MLC)两种模式,SLC模式存储密度低但可以保证高计算准确率,MLC模式计算存在误差但存储密度较高。HyFlexPIM在算法层利用SVD分解与微调技术,降低重要权重(具有较大梯度、需要高精度计算)的所占比例,从而节省低存储密度SLC的使用,最终兼顾存储密度与计算准确率。在基于SRAM介质的存内计算方面主要有两篇文章,分别是北京大学孙广宇教授团队联合东南大学司鑫教授团队、后摩智能提出的AIM,以及清华大学李兆麟教授与中山大学王明羽教授团队提出的MagiCache。AIM关注存内乘法计算中的电路IR-drop问题,在软件层引入汉明率正则项,在电路层支持自适应电压频率动态调整,最终达到了接近70%的IR-drop缓解。MagiCache针对Cache内计算的技术路径开展系统级优化,硬件层将cache行动态配置为计算行或存储行;软件层设计虚拟计算引擎,基于虚拟寄存器进行缓存空间管理,设计指令链式技术隐藏数据搬运延时,实现40%的缓存利用率提升。

ISCA 2025中出现的存内计算实现方式

存储系统优化:更大、更快、更安全

在 ISCA 2025 的纯存储系统优化专题中,研究者们既关注存储访问效率的极限提升,也聚焦于新型攻击对数据安全性的挑战。回顾存储安全领域的奠基工作,Onur Mutlu教授团队在 2014 年首次揭示了 DRAM row hammer 现象,开启了对 DRAM“读扰动”安全威胁的系统性研究。时隔十余年,随着 DDR5、PUF、存内计算等新技术的出现,row hammer的问题影响变得更加广泛,安全防护与性能开销之间的矛盾愈加突出。除了安全性之外,大规模数据分析与 大模型等AI 计算对存储子系统的访问效率提出了更高要求。针对上述背景,ISCA 2025 收录了多篇row hammer与存储系统优化工作,呈现出存储系统向“高效、安全、智能”多维度演进的趋势。

在row hammer防护方面,四篇工作的侧重点各有不同,分别从防护开销、防护方法以及新场景下的安全性问题等方面开展研究。佐治亚理工大学Moinuddin Qureshi教授团队提出的MoPAC关注在降低row hammer防护带来的性能损失,通过概率行激活计数的方法,在保证同等安全性的前提下降低更新计数器造成的时序开销。该团队的另一项工作DREAM在存储控制器侧,分析JEDEC DDR5引入的Directed Refresh Management (DRFM) 特性对row hammer的影响并进行优化。在挖掘新的安全性问题方面,英属哥伦比亚大学Prashant Jayaprakash Nair教授团队在 “When Mitigations Backfire”一文探讨了DDR5 行激活计数(Per Row Activation Counting, PRAC)中存在的timing channel 漏洞问题,提出了对应的侧信道攻击方法与防御策略。Onur Mutlu 教授团队的PuDHammer针对DRAM存内计算的多行激活特性,首次在商用DDR芯片上开展了系统性的读扰动影响评估。

在存储系统性能优化方面,阿联酋人工智能大学Chun Jason Xue教授团队提出的ArtMem与AMD提出的Folded Banks两篇文章分别从系统层和架构层开展了相关研究,通过软件智能算法驱动或硬件微架构创新实现对存储访问模式的动态适配,以达到带宽与延时的协同优化。ArtMem针对数据在多层级异构存储系统(DRAM内存+持久性内存及CXL扩展存储)中的迁移调度进行优化,利用强化学习方法学习数据的访问行为,动态地将数据页(page)放置在合适的存储层级,提高数据访问发生在DRAM中的相对比例,减少不必要的跨存储层级数据迁移开销。Folded Banks一文将视角聚焦在HBM上,着重解决HBM在随机访问场景下的有效带宽低的问题,创新性地在架构电路层提出将二维存储Bank“折叠”到三维堆栈中,实现短距离垂直互连,降低数据搬运开销,提高行激活的并行度。

Folded Banks存储架构

方向4:通用计算微架构设计与优化

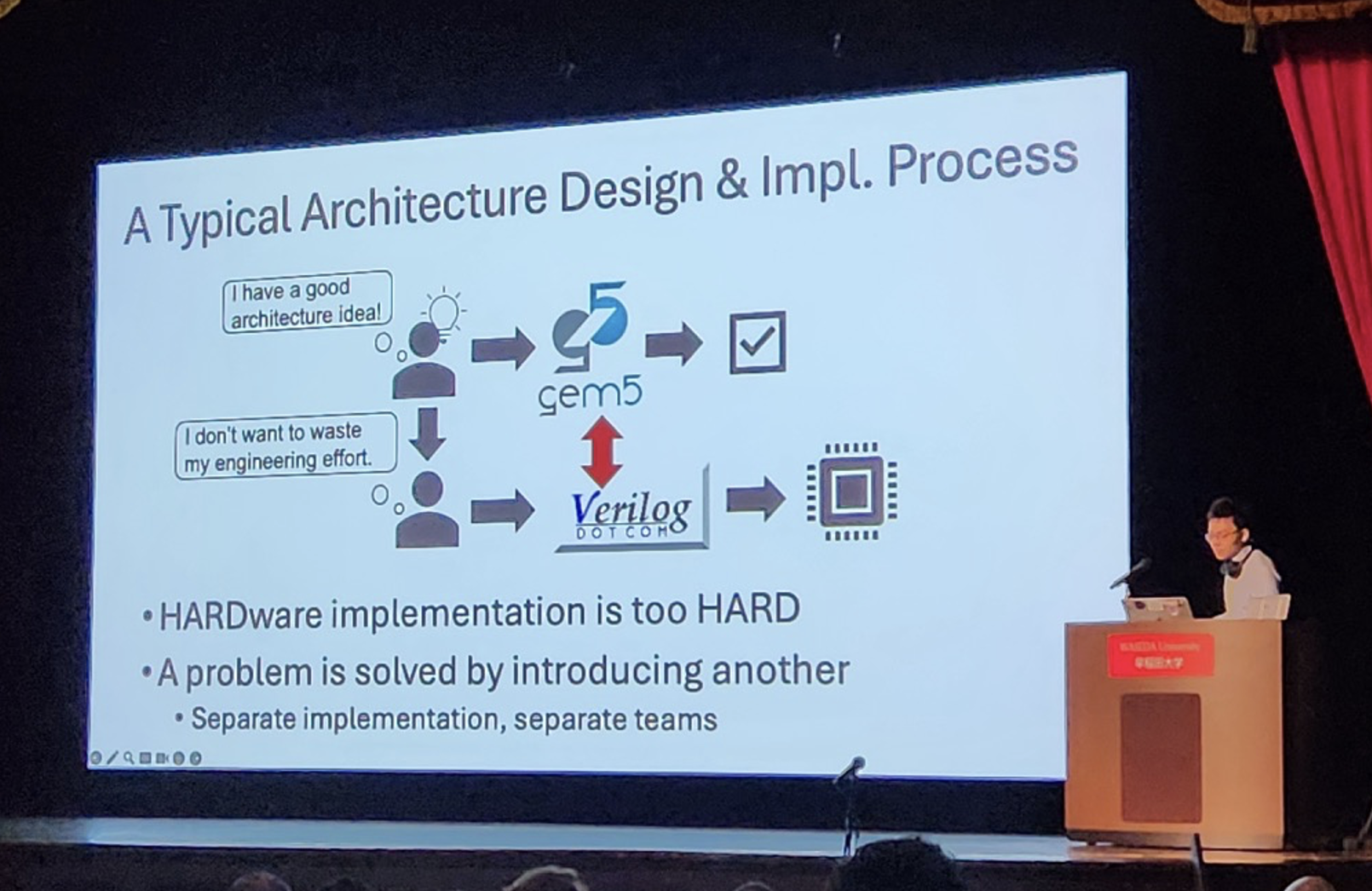

在LLM和定制加速器浪潮的席卷下,今年ISCA收录论文呈现出逐渐鲜明的结构转变,微架构领域的文章数量占比到达了近几年的低谷。这种变化折射出两大深层动因:其一,当前AI产业正处于爆发式增长期,大规模语言模型训练与推理过程中暴露的硬件性能瓶颈,成为学术界与产业界协同攻关的核心焦点,使得资源与研究方向向LLM专用加速技术倾斜;其二,历经数十年产业界和学术界深度融合,传统微架构研究已系统性探索了计算效率优化、指令集设计等核心议题,亟需突破现有方法论框架,借助更快捷高效的工具挖掘新的创新点。因此,近几年ISCA会议中关于性能建模、仿真工具链等方法论涌现并录用了越来越多的文章。

今年ISCA共安排了2个Session作为Microarchitecture的主阵地。在传统 CPU 架构研究领域,研究方向集中于分支预测、数据预取和缓存优化等方向,重点探讨了在多样化场景与资源约束条件下的架构设计方案。

在分支预测领域,Yale Patt团队带来的高性能超前预测技术,深入探讨了如何在能耗开销与超前预测精度之间取得平衡;另有研究利用control flow的相似性,有效降低预测错误率。数据预取方面,香港科技大学谢知遥教授团队利用PGO技术,提出了Prophet——使用计数器注入hints来指导优化片上metadata的存储管理。此外,西安交通大学任鹏举教授、夏天教授研究团队提出了基于循环特征进行预取的Magellan。

在cache设计与替换策略优化方面,也有一些非常好的工作,例如威斯康辛大学麦迪逊分校Joshua San Miguel 教授发表的 “The XOR Cache: A Catalyst for Compression”,成功入围今年的Best Paper Nomination。文章讨论了现代计算系统中,最后一级缓存(LLC)占用大量SRAM资源,导致芯片面积和功耗增加,而传统大缓存存在访问延迟高、效率低的问题。XOR Cache是一种新型压缩LLC架构,通过利用缓存层级中的包含性和私有缓存冗余,采用异或压缩技术存储线对的按位异或值,实现2:1的压缩比,将LLC数据阵列容量减半,还兼容 B∆I和Thesaurus的压缩方案。实验表明,XOR Cache可节省1.32倍LLC面积、1.67倍功耗,性能开销约为3.58%,有效平衡了缓存资源占用与性能需求。

同样探讨LLC性能的工作还有韩国延世大学Won Woo Ro教授团队的 “Garibaldi: A Pairwise Instruction-Data Management for Enhancing Shared Last-Level Cache Performance in Server Workloads”,该文章聚焦服务器工作负载中的令占用空间超过私有缓存容量,导致LLC中指令缺失的问题。Garibaldi提出了一种指令-数据成对管理方案,采用选择性保护机制防止高成本指令缓存行被逐出,并在访问未受保护的指令行时预取相关数据行,有效提升了服务器工作负载的性能。

关于GPU架构本身的创新,在此介绍一篇具有代表性的工作:新加坡国立大学Trevor E. Carlson 教授团队发表的 “The Sparsity-Aware LazyGPU Architecture”。文章提出了一种名为LazyGPU的新型GPU架构,旨在解决 GPU内存带宽瓶颈问题。传统GPU采用eager execution提前发出内存请求,但这会导致硬件竞争和资源利用不足。作者观察到,在CPU中已有相关研究的lazy execution其实更适合GPU的线程级并行性,仅在需要时发出内存请求,同时结合零缓存和特殊指令优化,消除不必要的内存访问从而提升了GPU的性能。

在计算机体系架构飞速发展的今天,性能建模作为破解设计瓶颈、加速迭代周期的核心利器,已成为学术界与工业界的共同焦点。近年来,该领域研究成果如雨后春笋,从通用架构的敏捷设计平台,到CPU、GPU及异构系统的深度性能剖析方案,一系列创新工具的涌现,为架构师们提供了前所未有的设计视角与优化路径。国王科技大学的Jian Weng教授团队提出了一种新的架构设计方法Assassyn,无需重复写不同维度下的硬件开发代码,而是能在统一的抽象框架下完成架构的仿真与实现,加速了当下复杂系统硬件的设计迭代。

Jian Weng教授汇报

另一项来自Google团队的工作Concord,采用了Analytical和轻量ML的混合办法对CPU进行建模,与cycle-level的仿真器比起来,Concord实现了五个数量级的速度提升,同时将性能预测精度控制在CPI级别。这一项研究也表明,基于AI的创新方法将持续拓展性能预测的精度与效率边界,在当下依旧有很大的研究空间。

方向5:密码学硬件设计研究

随着数字技术的发展,密码学的重要性日渐凸显。然而,传统的软件实现往往面临性能瓶颈,难以满足大规模实际应用的需求。近年来,硬件加速技术在密码学领域的应用呈现爆发式增长,零知识证明、同态加密,异构设备安全等方向都涌现出了大量的研究成果。

本文汇总了ISCA 2025的8项前沿研究,涵盖了北京航空航天大学、ETH Zurich、中科院信息工程研究所等多个知名机构的最新工作。这些研究在理论上实现了重要突破,或在工程实践中展现了巨大的应用潜力,为密码学技术的产业化和规模化应用铺平了道路。

这些密码学与硬件相结合的前沿研究共同反映了一个变化:传统的可信执行环境(TEE)方向在最新的研究热点中逐渐淡出,研究重心转向了更加根本性的密码学硬件加速和处理器安全机制。这一转变反映了学术界和工业界对于"从硬件底层构建安全"理念的认同,以及对密码学原生硬件加速需求的迫切性。随着Web3、隐私计算、安全多方计算等应用场景的扩大化、通用化、常态化,密码学硬件加速技术将成为数字世界安全的保障,为社会的数字化转型贡献力量。

零知识证明加速方案

零知识证明作为区块链和隐私计算的核心技术,正在经历从理论到实用的关键转折。

纽约大学Brandon Reagen教授团队的zkSpeed加速器通过专门优化HyperPlonk协议实现了相对于CPU Baseline的801倍的几何平均加速比。北京航空航天大学赵巍胜教授、杨建磊教授团队的Finesse框架则通过软硬件协同设计实现了从算法到硬件的自动化流程,相比传统方案在吞吐量上提升34倍;其提出的框架能方便硬件开发者在Security Bit需求持续增加时节省硬件重复开发的时间。

Finesse框架

除了本届ISCA这两篇文章外,自从21年以来,ASPLOS、MICRO、HPCA、DAC等会议上零知识证明相关加速的工作如雨后春笋般出现。追溯这个浪潮为何在这个时间节点发生,我们认为这来源于两点:第一,零知识证明的算法的发展在过去十年里的巨大突破(以2016年的Groth16和2019年的Plonk等划时代工作的出现为重要节点),使得这项技术从“密码学学界的玩具”变成了实际商业可行的技术。第二,在算法突破几年后,零知识证明在Web3领域产生了一些实际的业务需求,驱动了第一批需要大量零知识证明算力的公司。这些发展促使工业界和学界开始注重零知识证明加速硬件的研究和开发。

同态加密加速器

全同态加密(FHE)技术正在通过硬件加速克服计算冗长繁杂的困难,实现从理论到实用的根本性转变。

ISCA 2025中,中科院信息工程研究所侯锐研究员、蚂蚁技术研究院计算系统实验室副主任张明喆研究团队发表了两篇FHE加速文章。两项研究展现了两个不同的优化方向:FAST加速器通过支持混合密钥切换和KLSS方法的硬件实现,相比传统方案实现了1.8倍性能提升和44.4%的bootstrap延迟降低;Neo系统则开创性地利用GPU Tensor Core的FP64组件,通过算法-硬件协同优化实现了平均3.41倍的应用加速。

同态加密硬件加速器在四大会议上的发表自2018年至今,每一年都占据一定的版面。近八年突破的积累表明,FHE正在从学术研究走向工业应用,云计算时代的数据隐私保护有了切实可行的解决方案。随着硬件加速技术的不断成熟,FHE有望实现大规模商业化应用。此外蚂蚁集团和计算所的深度合作,也表现了工业界对于硬件加速同态算法的信心和投入决心。值得一提的是,尽管TFHE在理论学界被普遍认为是比CKKS更加先进的系统,但令人惊讶的是本届ISCA之中TFHE算法相关论文退出视野,CKKS算法占据了全部版面,这可能也是工业界对于更成熟、更有实用价值的算法的筛选作用。

硬件安全防御设计

硬件安全技术正在从被动防护转向主动安全设计,安全和性能两者兼顾的设计在本届ISCA会议中得到广泛关注。

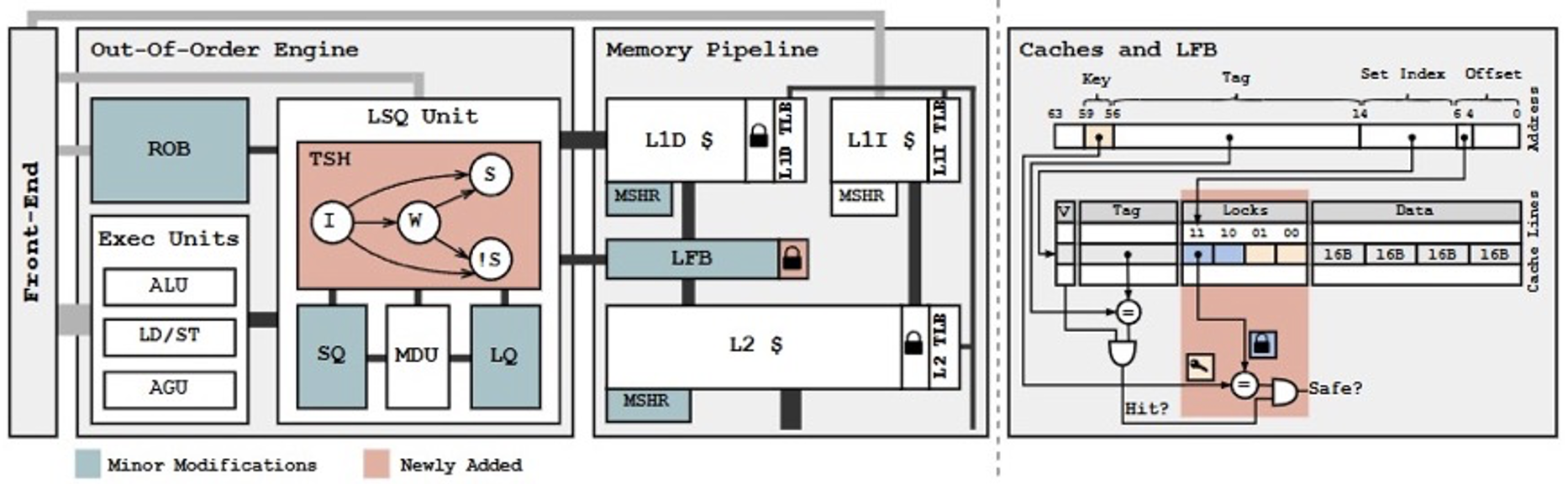

Trevor E. Carlson教授团队发表的Cassandra系统通过完全禁用分支预测器并记录重放控制流,消除了Spectre等侧信道攻击的根本原因,并实现了1.85%的性能提升,打破了安全必然牺牲性能的常识。加州大学河滨分校Nael Abu-Ghazaleh教授团队联合三星发表的SpecASan一文利用ARM内存标记扩展,将内存安全保护扩展到投机路径,仅用1.8%的性能开销就实现了对瞬态执行攻击的有效防护。

SpecASan系统架构

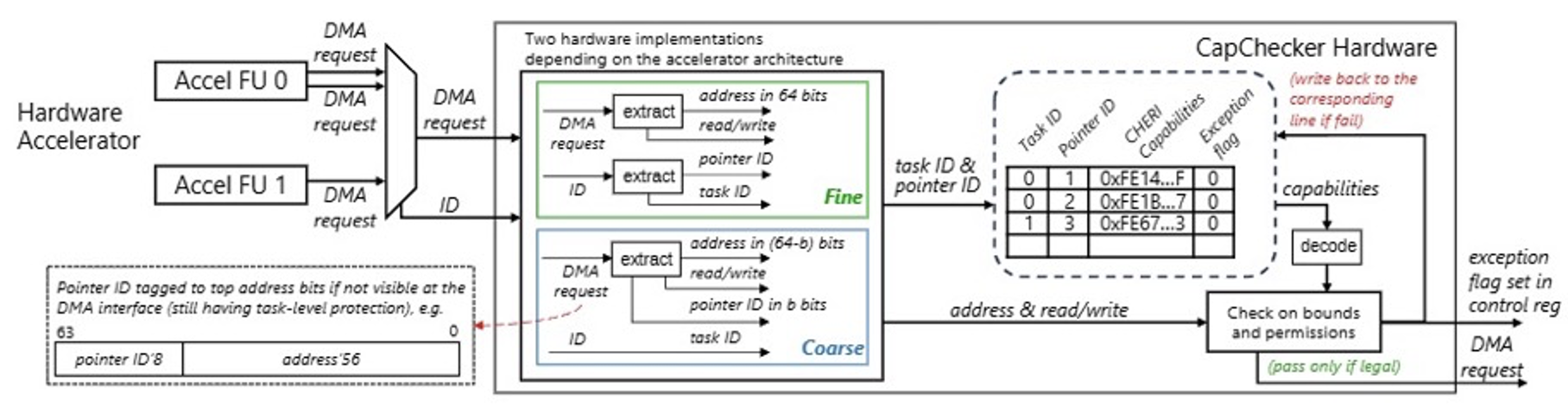

在异构系统安全方面,剑桥大学Timothy M. Jones教授团队联合爱丁堡大学发表的自适应CHERI方案,通过CapChecker组件为硬件加速器提供指针级细粒度内存保护,平均性能开销仅1.4%,是ISCA 2025该方向中最亮眼的设计之一。KAIST Jaehyuk Huh团队针对异构SoC设计了统一的64B到32KB多粒度保护方案,执行时间减少14.2%-21.1%。该工作代码已经在Zenodo上开源: https://doi.org/10.5281/zenodo.15100923。

CapChecker 架构设计

这些研究成果表明了两个趋势:第一,硬件安全的设计将逐渐融入到系统、架构设计之中,成为系统设计、架构优化不可或缺的一部分。第二,相比于之前先优化性能,再与防御设计相结合的硬件设计,将安全纳入性能计算成为论文投稿以及架构优化的新思路。两个趋势共同反映了未来的硬件安全将不再是性能的负担,而是系统优化的重要组成部分,安全性与性能的协同提升将成为硬件设计的新范式。

方向6:量子计算

当前量子计算研究正处于从含噪中规模量子(NISQ)向容错量子计算(FTQC)跨越的关键阶段,亟需体系结构层面的创新,以搭建物理实现与算法应用之间的核心桥梁。体系结构研究关注优化硬件设计、容错机制及编译策略等,以解决量子比特扩展性、噪声抑制和计算可靠性等核心挑战,为实用化量子计算机奠定基础。从近年来国际体系结构会议和期刊收录的文章不难看出,体系结构领域日益重视量子计算研究,致力于为大规模量子计算机构建坚实的架构支撑。

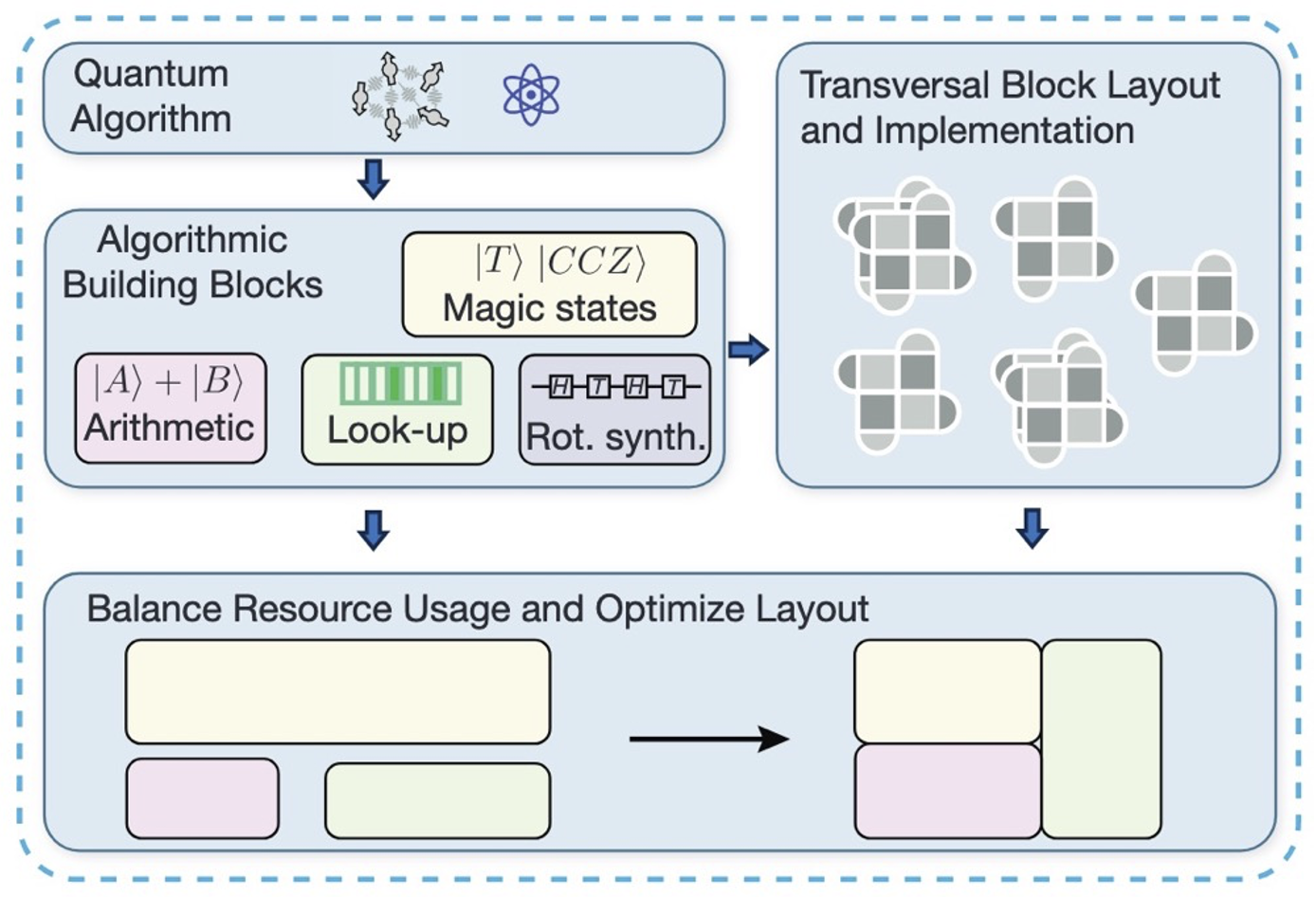

ISCA 2025会议特设三个量子计算专题会场,收录16篇来自全球顶尖学术机构与工业界的前沿研究成果。其中三篇为中国团队发表(浙江大学两篇、香港科技大学(广州)一篇),这是ISCA历史上首次收录中国研究团队的量子计算文章。这些工作从量子编译优化、硬件架构设计、量子互联架构、容错编码机制及FTQC系统设计等维度,全面推动了量子计算技术的实用化进程。

迈向容错——量子计算架构研究的新风向

基于量子纠错编码的容错量子计算以及量子计算机互联是本次量子计算专题中的一大方向。ISCA 2025中近乎一半的量子计算文章是在围绕这一主题并从不同的侧重点探讨如何系统化解决大规模容错量子计算中的挑战。

QuEra Computing 与学术界团队合作提出了一种基于中性原子阵列的低开销横向架构。该架构利用动态可重构连接和快速横向操作,显著提升了容错电路的运行效率。他们的架构采用功能构建块(如魔术态工厂、量子算术逻辑单元和量子查找表)的模块化设计,实现了空间-时间成本的显著降低。借助这一架构,2048位RSA因式分解可在5.6天内用1900万个量子比特完成,相比现有方案估计实现了50倍的加速。另一篇来自 QuEra 和学术界和合作成果同样带有优美的理论色彩,其针对量子互联中的纠缠资源蒸馏问题,提出了恒定速率纠缠蒸馏方法。通过使用递增速率的量子错误检测码序列,他们的方案在期望水平下实现了恒定通信开销,物理纠缠态与逻辑纠缠态的比率保持恒定。实验结果显示,在5%的网络通信错误率下,该方法比现有方案降低了13.5倍的通信开销。出自加州大学圣地亚哥分校Yufei Ding教授团队的SwitchQNet 一文同样侧重分布式量子计算的扩展问题,其中所提出的编译器设计通过程序层和网络层的协同优化来降低跨机柜之间通信延迟,这种编译器框架特别适合本地范围(如单个房间或设施内)的量子处理器互联。另一篇容错计算的架构工作 EFT-VQA来自于美国芝加哥大学,聚焦于在一个有着有限纠错资源但仍不足以实现完全FTQC的阶段如何凸显早期容错(early fault tolerance, EFT)中的量子应用优势。该研究基于部分量子纠错编码(pQEC)方案和变分量子算法(VQA)的程序特性,提出了一系列 pQEC 架构优化技术。在仅对 Clifford 门进行纠错、而对 Rz(θ) 旋转采用魔法态注入的前提下(而非传统FTQC中资源代价甚大的 Clifford+T 电路分解和 T 态蒸馏方案),EFT-VQA 在 10⁴ 物理比特规模下的普遍表现显著优于NISQ和完全容错方案。

基于中性原子的横向容错计算架构

另外三篇文章则分别从逻辑操作同步、比特校准、实时解码等方面提出创新方案来提升FTQC电路的运行时性能。为了解决FTQC尤其异构FTQC电路运行中逻辑比特操作的同步问题,威斯康辛大学麦迪逊分校Swamit Tannu教授团队在 “Synchronization for Fault-Tolerant Quantum Computers” 一文中,提出了主动、被动和混合三种同步策略,最高能将逻辑错误率降低3.4倍、解码延迟减少2.2倍,从而缓解了异构FTQC系统中各个逻辑编码块因不同纠错周期导致的不同步问题。Yufei Ding教授团队所提出的 CaliQEC 方案试图通过编译优化的手段解决大规模FTQC电路中量子比特高效率校准的问题。针对表面码量子纠错中的比特误差漂移问题,CaliQEC 通过纠错码变形指令集隔离待校准量子位,同时保持计算连续性,从而实现运行时原位校准。芝加哥大学的Fred Chong研究团队提出的预测性窗口解码方案 SWIPER 旨在最小化实时量子纠错中的解码延迟。受经典计算机分支预测的启发,SWIPER 采用一个轻量级预测器来推测相邻解码窗口之间的数据依赖关系,从而允许不同解码任务并行进行,有效减少了整体解码延迟。实验结果表明 SWIPER 相比已有的并行窗口解码方案能将FTQC电路运行时平均减少40%。

![并行窗口解码对比推测性窗口解码 [SWIPER]](/post/2025/25.09.08-isca-summary/assets/index/1757567480530_image.png)

并行窗口解码对比推测性窗口解码 [SWIPER]

体系重构——从底层校准到顶层编译的深度优化

ISCA 2025 同样呈现出"量子-经典"计算系统协同创新、多物理体系协同编译、系统级硬件优化等趋势。

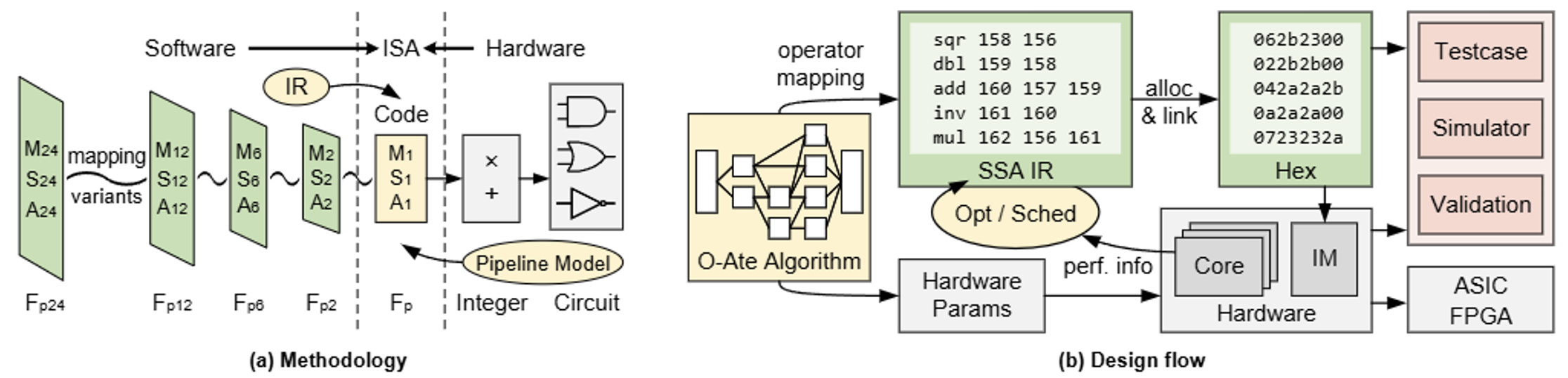

匹兹堡大学的Xulong Tang教授团队提出的 RLGS 编译框架,创造性地将强化学习和图神经网络结合,显著优化了光量子图态生成序列的三大关键指标(生成时间、发射器数量、CZ门数量)。借助精心设计的动态奖励函数和感受野策略,RLGS 能够均能将大、中、小规模图态的生成时间分别平均减少57.5%、49.6%和31.1%,同时显著减少了发射器和CZ门的使用数量。Prashant Jayaprakash Nair教授团队提出的TQSim 一文通过计算重用方法加速含噪量子电路在经典计算机上模拟运行性能。TQSim 所采取的动态电路分区将电路划分为可重用的子电路单元,利用中间状态复用减少冗余计算,并采用树形结构管理子电路间的状态共享,支持CPU/GPU多节点部署。来自浙江大学尹建伟教授、卢丽强研究员团队的 Qtenon 工作直击混合量子-经典计算的通信瓶颈,所提出的紧耦合加速系统通过统一内存层次、高效量子控制器等硬件设计,实现量子与经典部分的低延迟协同,并且通过扩展的 RISC-V 指令集统一各层次硬件控制语义。这三篇文章可称作量子计算与高性能计算/人工智能(HPC/AI)系统相结合的典范,为如何借鉴经典计算的成熟技术来攻克量子系统规模化、高效化等核心挑战,提供了清晰的路线图与实现范例。

在一般性的量子程序执行层面,Won Woo Ro教授团队的QR-Map 提出基于映射的量子比特复用方案,通过将量子线路抽象为二维地图来高效地捕捉计算依赖关系,从而高效、确定性地识别量子比特复用机会;另有工作关注执行量子电路中反馈延迟过高这一核心瓶颈,尹建伟教授、卢丽强研究员团队提出 ARTERY 框架以融合对历史分支信息的统计和对读出脉冲轨迹的实时分析,建立了一个高精度的预测模型以掩盖了传统反馈回路中漫长的等待延迟,亦是将分支预测思想引入量子计算程序执行的启发性创新。

当前主流量子硬件平台仍然是以 transmon 为代表的超导量子比特,并大致分为可调频率可调耦合(以Google硬件为代表)和固定频率固定耦合(以IBM硬件为代表)两种类型,因此针对此类底层硬件设计和控制优化依然会是量子计算领域长期的研究挑战。ISCA 2025 中两篇文章关注如何为类似 IBM 超导比特和指令集开发更好的硬件优化策略。杜克大学陈怡然教授团队提出的QPlacer 是一个频率感知的自动化布局框架,优化 transmon 比特和耦合器排布以解决量子芯片中频率串扰问题。QPlacer 将量子组件类比为带电粒子,利用一种“频率排斥力”的概念,在空间上主动分离频率相近的组件,从而系统性地抑制串扰,同时保持芯片面积的紧凑。相比传统布局方案,QPlacer 能够将系统保真度提升37.5倍,空间串扰违例减少12.76倍。另一篇来自于伦斯勒理工学院Zhiding Liang教授团队的工作则关注量子门(IBM上一代硬件常用的 CR 门)校准问题。硬件上实现高保真度量子门尤其两比特门依赖时间代价较高的周期性的校准过程,该工作提出细粒度的校准策略和并行化方法优化量子门控制参数。在IBM 127-qubit真机上的测试结果验证了协议的有效性,实验结果表明该方法能将两比特量子门错误率中位数降低1.84倍,脉冲持续时间减少1.26倍,总校准开销减少8至25倍。

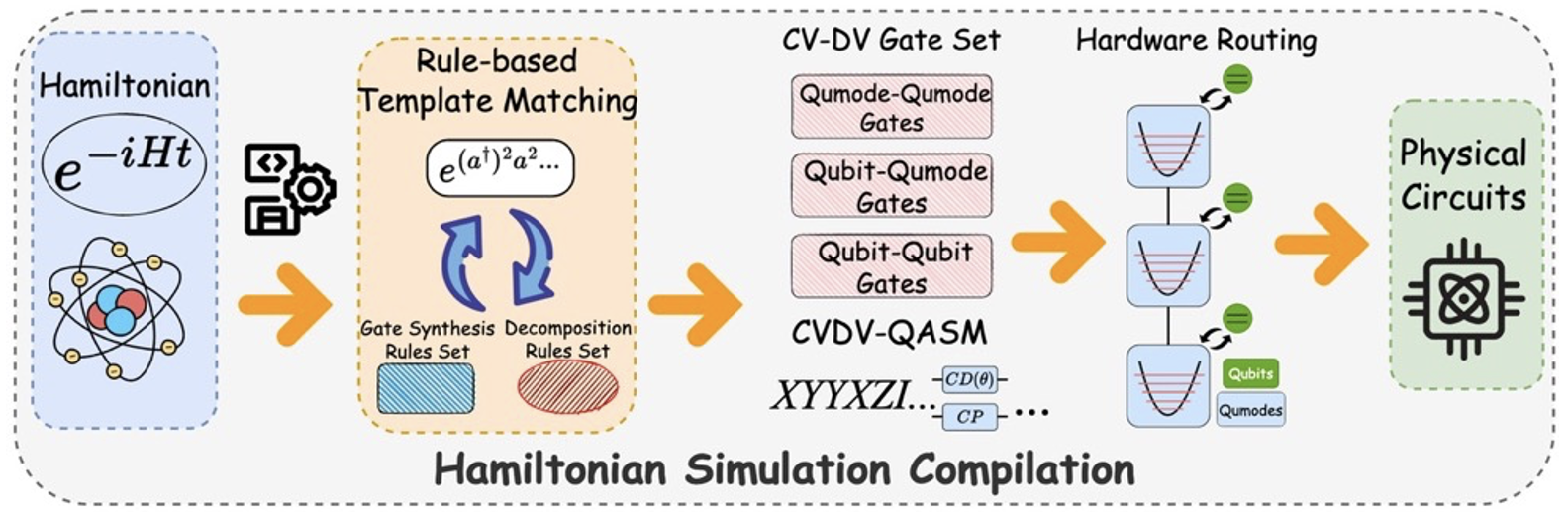

此外,本专题同样关注在非超导体系的系统性研究。除了前述所基于中性原子的横向容错架构工作,另外两篇侧重编译优化的论文分别基于离子阱和连续-离散变量混合平台。香港科技大学(广州)王鑫教授团队提出的S-SYNC 关注离子阱领域的量子电荷耦合器件(QCCD)架构所带来的特殊硬件约束和协同优化机会,提出提出通用交换(generic-swap)操作统一建模例子穿梭与量子比特交换门,并利用启发式搜索算法来同时最小化穿梭和交换的开销。S-SYNC 能将穿梭次数平均减少3.69倍,并将量子应用的成功率平均提升1.73倍,提升了QCCD离子阱量子计算机的并行性和效率。罗格斯特大学Eddy Z. Zhang教授团队的Genesis支持将哈密顿量模拟程序映射连续-离散变量(CV-DV)混合量子计算平台(以Amazon硬件为代表)。以超导-谐振腔耦合体系为例,这类CV-DV混合架构在模拟包含费米子和玻色子的物理系统方面极具潜力,但其独特的硬件特性给编译器设计带来了较大挑战。Genesis 采用两级编译流程,首先将哈密顿量分解为混合CV-DV系统的原生门,然后通过集成的门合成与交换门插入策略,解决硬件连接受限的映射与路由问题。研究成果展示,Genesis成功编译了多个在量子化学和凝聚态物理中备受关注的哈密顿量模型(如Bose-Hubbard模型),为在混合量子计算机上进行复杂的物理模拟提供了首个完整的自动化编译方案。

Genesis框架